Anthropic acaba de endurecer las normas sobre el uso de Claude. La nueva política de uso es muy específica: no se permite la generación de malware, la asistencia para hackers, la manipulación política y el contacto con armas (desde armas nucleares hasta biológicas). Estas prohibiciones se aplican a Claude en el uso de cara al consumidor. Las implementaciones empresariales tienen mayor margen de maniobra.

¿Qué está diciendo Anthropic?

Anthropic admite que la razón es su propio progreso. Las nuevas funciones de tipo agente (Código Claude y Uso de Computadoras) son lo suficientemente potentes como para plantear riesgos reales. En sus palabras:

“Estas potentes capacidades introducen nuevos riesgos, incluido el potencial de abuso a gran escala, creación de malware y ciberataques”.

Traducción: las herramientas funcionan lo suficientemente bien como para que su mal uso se convierta ahora en una amenaza real.

Qué significa (en palabras humanas)

Si estás construyendo con Claude para cosas como:

Hackear sistemas, encontrar vulnerabilidades, crear malware o ejecutar ataques de denegación de servicio.

Fabricación de explosivos o armas QBRN (químicas, biológicas, radiológicas, nucleares).

Operaciones políticas diseñadas para “perturbar los procesos democráticos” o atacar a los votantes.

La versión más corta -o llamémosla simplemente la declaración oficial- es: no puedes.

Lo que significa que la empresa ahora tiene:

Líneas rojas en negrita. Se acabó esconderse tras la excusa de "no conocíamos las reglas". Anthropic las puso por escrito.

La seguridad del consumidor es lo primero. Si Claude tiene contacto con el público, se aplica la política estricta. Enterprise tiene más espacio, pero no lo confunda con un pase libre.

La seguridad de la IA hecha realidad. Estos riesgos ya no son teóricos. Ciberdelincuencia, intromisión electoral, armas... Anthropic afirma que los casos extremos son ahora amenazas comunes.

Conectando los puntos

Los proveedores de LLM están comenzando a tomar conciencia del mundo en el que vivimos y a tomar una postura.

La misión de Anthropic

Anthropic se posiciona como una empresa de IA de beneficio público con un claro objetivo: construir sistemas de IA confiables, interpretables y manejables que beneficien a la humanidad a largo plazo.

Compartiendo los números

Hablemos de escala y señal. Claude ya no es un nicho:

Aproximadamente 19 millones de usuarios activos mensuales a nivel mundial, de los cuales unos 2,9 millones acceden a la aplicación cada mes. Cabe destacar que solo EE. UU. e India representan el 33,13 % de esa base.

La demografía se inclina hacia los jóvenes y hombres: aproximadamente el 77 % son hombres, y el grupo de edad de 18 a 24 años representa más de la mitad de los usuarios activos. El siguiente grupo más grande es el de 25 a 34 años.

Detrás de escena, Anthropic está logrando cientos de millones de descargas de aplicaciones y se dirige hacia una tasa de ingresos anuales de miles de millones de dólares, lo que demuestra que Claude no solo se usa, sino que se adopta.

La ciberseguridad, en cifras

El panorama de amenazas impulsado por IA está aumentando, y así se verá en 2025:

El 85% de los líderes en ciberseguridad afirman que la IA generativa está aumentando directamente el volumen y la sofisticación de los ciberataques.

Solo en el segundo trimestre de 2025 se bloquearon 142 millones de enlaces de phishing generados por IA, un salto respecto del trimestre anterior.

Las autoridades indias informan que el 82,6% de los correos electrónicos de phishing ahora utilizan herramientas de inteligencia artificial.

Los ciberdelincuentes ejecutan 36.000 escaneos automatizados por segundo, lo que da como resultado que 1.700 millones de credenciales robadas inunden la red oscura.

Y las infracciones vinculadas a herramientas de IA ocultas o no autorizadas (también conocidas como “IA en la sombra”) cuestan a las organizaciones un promedio de 670.000 dólares adicionales.

En resumen

Qué cambió:

Las líneas rojas son explícitas: no se permiten ciberataques, armas ni interferencias electorales.

Aplicaciones de consumo = reglas más estrictas.

Empresa = mayor flexibilidad, pero no un pase libre.

Ponlo en marcha:

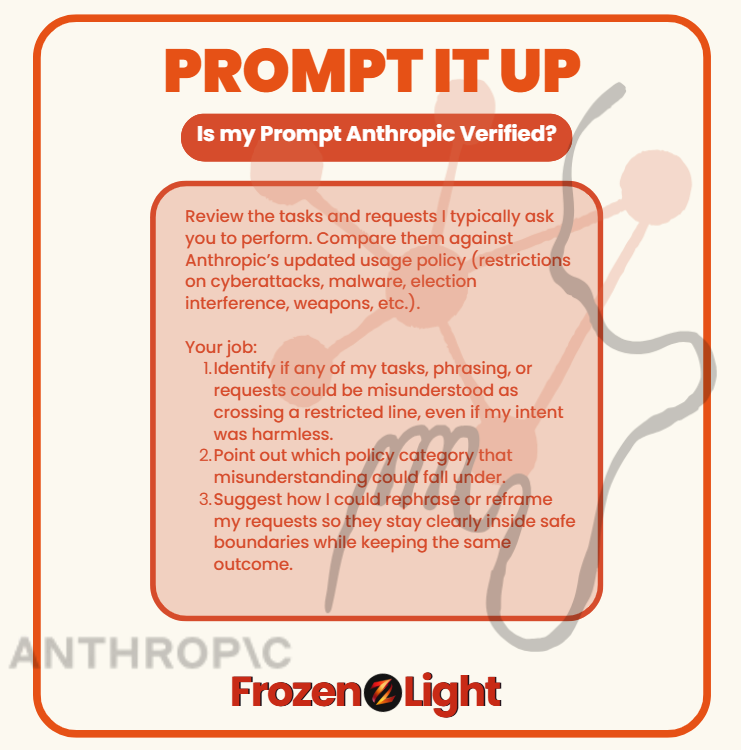

La mayoría de nosotros no usamos a Claude (ni ningún otro LLM) para crear malware, hackear elecciones ni fabricar armas. Pero con la nueva política de Anthropic, incluso tareas inocentes podrían malinterpretarse si se formulan de forma incorrecta.

Es mejor verificar antes de que te marquen por algo que nunca pretendiste.

Copiar y pegar

Revise las tareas y solicitudes que suelo solicitarle. Compárelas con la política de uso actualizada de Anthropic (restricciones a ciberataques, malware, interferencia electoral, armas, etc.).

Tu trabajo:

Identificar si alguna de mis tareas, frases o solicitudes podrían malinterpretarse como cruzar una línea restringida, incluso si mi intención era inofensiva.

Señale en qué categoría de políticas podría incluirse ese malentendido.

"Sugiera cómo podría reformular o replantear mis solicitudes para que se mantengan claramente dentro de límites seguros y al mismo tiempo obtengan el mismo resultado".

Ejecute esto en cualquier LLM y auditará cómo solicita las cosas, mostrándole si su estilo podría parecer una violación de la política, incluso cuando no está haciendo nada malo.

Perspectiva del equipo Frozen Light

¿Qué podemos decir? La experiencia importa. Cuanto más tiempo llevas haciendo algo, mejor te vuelves. Nada en la nueva política de Anthropic es realmente nuevo. No es que de repente descubrieran que su LLM podía ser mal utilizado. Siempre lo han sabido.

Entonces ¿qué pasó ahora?

Desde el primer día, la misión de Anthropic ha sido "en beneficio de la humanidad". Sus fundadores dejaron OpenAI con esa promesa en su bandera. Pero si lees la política actualizada , notarás que falta algo: ya no se expresa en el mismo lenguaje de beneficio humano con el que solían definirse.

Para nosotros, esto se siente como un cambio que viene con la experiencia. Un paso del idealismo al realismo. No es que los riesgos no existieran antes, sino que ahora Anthropic ya no puede ignorarlos.

Y si has usado LLM, conoces la sensación: pides algo inofensivo y, de repente, el modelo se niega. Te encuentras con un obstáculo sin explicación. Frustrante, ¿verdad? Pero a menudo, ese rechazo ocurre porque tu solicitud parecía un uso indebido, incluso si tu intención era la contraria.

Tomemos como ejemplo la ciberseguridad: preguntar cómo funciona un ataque puede implicar preparar las defensas. Tiene sentido. Pero para el modelo, puede ser exactamente igual que planificar un ataque. Esa es la tensión a la que se enfrenta Anthropic.

Entonces, ¿qué creemos que han decidido? Dos posibilidades:

Opción 1: Lavarse las manos. Eliminar cualquier actividad que parezca arriesgada, tanto en ataque como en defensa. Si ese es el caso, no está bien. Eso deja a los constructores a ciegas.

Opción 2: Trazar límites más nítidos. Aprender de la experiencia, reconocer que el mal uso y la protección pueden parecer similares, e intentar definir la diferencia. Si esto es así, ¡bien por ellos! Queremos que Claude forme parte de la defensa, no solo de la evasión.

Porque lo que más odiamos es cuando sucede algo y nosotros, los constructores, los usuarios, no estamos incluidos en la conversación.

En cierto modo sentimos que esto es lo que está sucediendo aquí: alguien tomó una decisión por todos nosotros.

Y ya sea lavarnos las manos o trazar líneas más claras, la elección no fue nuestra, pero viviremos con las consecuencias.