قامت أنثروبيك مؤخرًا بتشديد قواعد استخدام كلود. سياسة الاستخدام الجديدة مُحددة للغاية: ممنوع توليد البرامج الضارة، ممنوع مساعدة القرصنة، ممنوع التلاعب السياسي، ممنوع لمس الأسلحة (من الأسلحة النووية إلى البيولوجية). تُطبق هذه المحظورات على كلود في الاستخدام المُوجه للمستهلكين. تُتاح للشركات مساحة أكبر للمناورة.

ماذا يقول الأنثروبي؟

تُقرّ شركة أنثروبيك بأن السبب هو تقدمها الخاص. فالميزات الجديدة الشبيهة بالوكلاء (مثل كلود كود واستخدام الكمبيوتر) قوية بما يكفي لإثارة مخاطر حقيقية. على حدّ تعبيرهم:

"إن هذه القدرات القوية تطرح مخاطر جديدة، بما في ذلك إمكانية إساءة الاستخدام على نطاق واسع، وإنشاء البرامج الضارة، والهجمات الإلكترونية."

الترجمة:الأدوات تعمل بشكل جيد بما فيه الكفاية بحيث أصبح سوء الاستخدام الآن تهديدًا حقيقيًا.

ماذا يعني ذلك (بالكلمات البشرية)

إذا كنت تقوم بالبناء مع كلود لأشياء مثل:

اختراق الأنظمة، والعثور على نقاط الضعف، وإنشاء البرامج الضارة، أو تنفيذ هجمات رفض الخدمة.

تحضير المتفجرات أو الأسلحة الكيميائية أو البيولوجية أو الإشعاعية أو النووية.

العمليات السياسية المصممة لـ"تعطيل العمليات الديمقراطية" أو استهداف الناخبين.

النسخة المختصرة - أو دعنا نسميها البيان الرسمي - هي: لا يمكنك ذلك.

وهذا يعني أن الشركة لديها الآن:

خطوط حمراء غامقة. لا مزيد من الاختباء وراء عبارة "لم نكن نعرف القواعد". أنثروبيك وثّقتها.

سلامة المستهلك أولاً. إذا كان كلود يتعامل مع الجمهور، تُطبق السياسة الصارمة. يحصل إنتربرايز على مساحة أكبر، ولكن لا تخلط بين ذلك وبين تصريح مجاني.

سلامة الذكاء الاصطناعي أصبحت حقيقة. لم تعد هذه المخاطر نظرية. الجرائم الإلكترونية، والتدخل في الانتخابات، والأسلحة - تقول منظمة أنثروبيك إن الحالات الهامشية أصبحت الآن تهديدات رئيسية.

ربط النقاط

بدأ بائعو برامج الماجستير في القانون في الاستيقاظ على العالم الذي نعيش فيه - واتخاذ موقف.

مهمة أنثروبيك

تضع شركة أنثروبيك نفسها كشركة ذكاء اصطناعي ذات منفعة عامة ولديها هدف واضح: بناء أنظمة ذكاء اصطناعي موثوقة وقابلة للتفسير والتوجيه تفيد البشرية على المدى الطويل.

مشاركة الأرقام

لنتحدث عن النطاق والإشارة. كلود لم يعد متخصصًا:

حوالي ١٩ مليون مستخدم نشط شهريًا حول العالم، منهم حوالي ٢.٩ مليون يستخدمون التطبيق شهريًا. والجدير بالذكر أن الولايات المتحدة والهند وحدهما تُمثلان ٣٣.١٣٪ من هذه القاعدة.

التركيبة السكانية تميل إلى الشباب والذكور - حوالي 77% ذكور، وتشكّل الفئة العمرية 18-24 أكثر من نصف المستخدمين النشطين. أما الفئة العمرية 25-34 فهي ثاني أكبر فئة.

خلف الكواليس، تجذب Anthropic مئات الملايين من عمليات تنزيل التطبيقات وتتجه نحو تحقيق معدل إيرادات سنوية بمليارات الدولارات، مما يثبت أن Claude ليس مجرد تطبيق مستخدم، بل تم تبنيه.

الأمن السيبراني بالأرقام

يتصاعد التهديد الذي تشكله الذكاء الاصطناعي، وهذا ما يبدو عليه في عام 2025:

يقول 85% من قادة الأمن السيبراني إن الذكاء الاصطناعي التوليدي يزيد بشكل مباشر من حجم وتعقيد الهجمات السيبرانية.

تم حظر 142 مليون رابط تصيد تم إنشاؤه بواسطة الذكاء الاصطناعي في الربع الثاني من عام 2025 فقط - وهي زيادة عن الربع السابق.

تشير التقارير الصادرة عن السلطات الهندية إلى أن 82.6% من رسائل التصيد الاحتيالي تعتمد الآن على أدوات الذكاء الاصطناعي.

يقوم مجرمو الإنترنت بإجراء 36000 عملية مسح آلية في الثانية، مما يؤدي إلى سرقة 1.7 مليار بيانات اعتماد وإغراق شبكة الويب المظلمة.

وتكلف الخروقات المرتبطة بأدوات الذكاء الاصطناعي المخفية أو غير المصرح بها (المعروفة أيضًا باسم "الذكاء الاصطناعي الظلي") المؤسسات 670 ألف دولار إضافية في المتوسط.

خلاصة القول

ما الذي تغير:

الخطوط الحمراء واضحة: لا هجمات إلكترونية، ولا أسلحة، ولا تدخل في الانتخابات.

تطبيقات المستهلك = قواعد أكثر صرامة.

المشروع = مزيد من المرونة، ولكن ليس مرورًا مجانيًا.

اطرحها:

لا يستخدم معظمنا برنامج كلود (أو أي برنامج ماجستير قانون آخر) لبناء البرمجيات الخبيثة، أو اختراق الانتخابات، أو صنع الأسلحة. ولكن مع سياسة أنثروبيك الجديدة، حتى المهام البسيطة قد تُساء فهمها إذا صيغت بطريقة خاطئة.

من الأفضل التحقق قبل أن يتم إرشادك لشيء لم تقصده أبدًا.

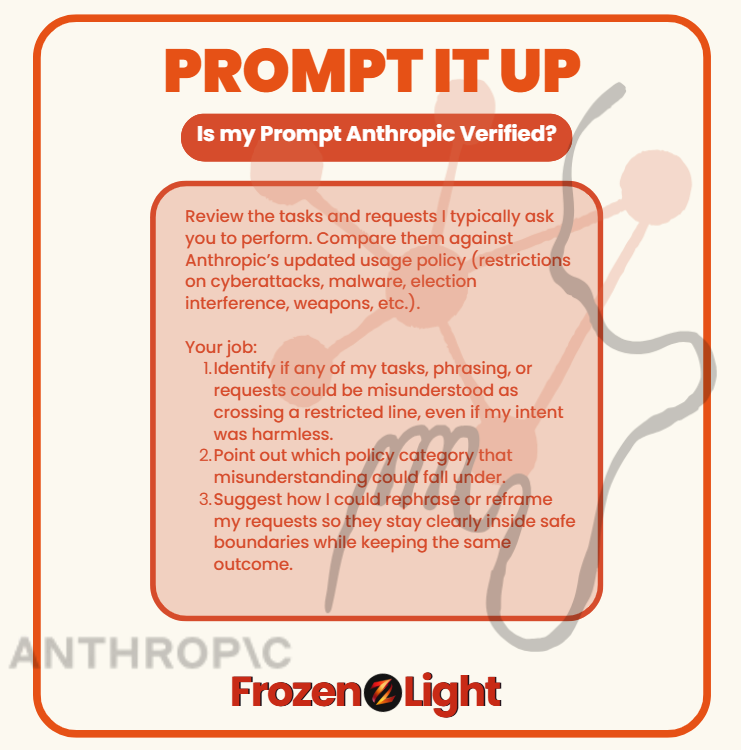

نسخ ولصق

راجع المهام والطلبات التي أطلب منك عادةً تنفيذها. قارنها بسياسة الاستخدام المُحدّثة لشركة Anthropic (القيود على الهجمات الإلكترونية، والبرامج الضارة، والتدخل في الانتخابات، والأسلحة، وما إلى ذلك).

وظيفتك:

حدد ما إذا كان من الممكن إساءة فهم أي من مهامي أو صياغتي أو طلباتي على أنها تجاوز لخط محظور، حتى لو كانت نيتي غير ضارة.

أشر إلى فئة السياسة التي قد يقع تحتها سوء الفهم هذا.

اقترح كيف يمكنني إعادة صياغة أو إعادة صياغة طلباتي بحيث تظل واضحة داخل الحدود الآمنة مع الحفاظ على نفس النتيجة.

⚡ قم بتشغيل هذا في أي برنامج LLM وسوف يقوم بفحص كيفية طلبك للأشياء - مما يوضح لك ما إذا كان أسلوبك قد يبدو وكأنه انتهاك للسياسة، حتى عندما لا تفعل شيئًا خاطئًا.

منظور فريق الضوء المتجمد

ماذا عسانا أن نقول؟ الخبرة مهمة. كلما زادت مدة ممارستك لها، تتحسن مهاراتك. لا شيء في سياسة أنثروبيك الجديدة جديد تمامًا. ليس الأمر أنهم اكتشفوا فجأةً إمكانية إساءة استخدام شهادة الماجستير في القانون. لطالما كانوا على دراية بذلك.

فماذا حدث الآن؟

منذ البداية، كانت مهمة أنثروبيك "خدمة الإنسانية". وقد ترك مؤسسوها شركة OpenAI حاملين هذا الوعد. ولكن إذا قرأتَ السياسة المُحدّثة ، ستلاحظ شيئًا مفقودًا: لم تعد تتحدث بنفس لغة خدمة الإنسانية التي اعتادوا تعريف أنفسهم بها.

يبدو لنا هذا تحولاً مكتسباً من الخبرة. انتقال من المثالية إلى الواقعية. ليس الأمر أن المخاطر لم تكن موجودة من قبل، بل إن أنثروبيك لم يعد بإمكانها تجاهلها.

وإذا كنت قد استخدمتَ برامج ماجستير القانون، فأنت تعرف ذلك الشعور: تطلب شيئًا غير مؤذٍ، وفجأةً يرفضه النموذج. تصطدم بحائطٍ لا تفسير له. أمرٌ محبط، أليس كذلك؟ ولكن في كثير من الأحيان، يحدث هذا الرفض لأن طلبك بدا وكأنه إساءة استخدام، حتى لو كانت نيتك عكس ذلك.

لنأخذ الأمن السيبراني على سبيل المثال: قد يكون التساؤل عن كيفية عمل الهجوم مرتبطًا بإعداد الدفاعات. هذا منطقي. لكن بالنسبة للنموذج، قد يبدو الأمر أشبه بالتخطيط لهجوم. هذا هو التوتر الذي تواجهه أنثروبيك.

إذن، ما الذي نعتقد أنهم قرروه؟ هناك احتمالان:

الخيار الأول: غسل أيديهم. إيقاف أي نشاط حتى لو بدا محفوفًا بالمخاطر، سواءً في جانب الهجوم أو الدفاع. إذا كان الأمر كذلك، فهذا ليس جيدًا. هذا يُغفل البناة.

الخيار الثاني: رسم حدود أكثر وضوحًا. التعلم من التجربة، وإدراك أن إساءة الاستخدام والحماية قد تبدوان متشابهتين، ومحاولة تحديد الفرق. إذا كان هذا هو ما توصلنا إليه، فحسنًا. نريد أن يكون كلود جزءًا من الدفاع، وليس مجرد التجنب.

لأن ما نكرهه أكثر هو عندما يحدث شيء ما، ونحن - البناة والمستخدمون - لا نكون مشمولين بالمحادثة.

نشعر أن هذا هو ما يحدث هنا: لقد اتخذ شخص ما قرارًا نيابة عنا جميعًا.

وسواء كان الأمر يتعلق بغسل أيديهم أو رسم خطوط أكثر وضوحًا، فإن الاختيار لم يكن من اختيارنا - ولكننا سنتعايش مع العواقب.