Anthropic vient de durcir les règles d'utilisation de Claude. La nouvelle politique d'utilisation est très précise : pas de création de malware, pas d'aide au piratage, pas de manipulation politique, pas de manipulation d'armes (des armes nucléaires aux armes biologiques). Ces interdictions s'appliquent à Claude pour les applications grand public. Les déploiements en entreprise bénéficient d'une plus grande marge de manœuvre.

Que dit Anthropique ?

Anthropic admet que la raison réside dans ses propres progrès. Les nouvelles fonctionnalités de type agent (Claude Code et Computer Use) sont suffisamment puissantes pour engendrer de réels risques. Selon eux :

« Ces puissantes fonctionnalités introduisent de nouveaux risques, notamment un potentiel d’abus à grande échelle, de création de logiciels malveillants et de cyberattaques. »

Traduction : les outils fonctionnent suffisamment bien pour que leur mauvaise utilisation constitue désormais une menace réelle.

Ce que cela signifie (en termes humains)

Si vous construisez avec Claude pour des choses comme :

Pirater des systèmes, trouver des vulnérabilités, créer des logiciels malveillants ou exécuter des attaques par déni de service.

Fabrication d’explosifs ou d’armes NRBC (chimiques, biologiques, radiologiques, nucléaires).

Opérations politiques conçues pour « perturber les processus démocratiques » ou cibler les électeurs.

La version courte – ou appelons-la simplement la déclaration officielle – est : vous ne pouvez pas.

Ce qui signifie que l'entreprise dispose désormais de :

Lignes rouges en gras. Plus besoin de se cacher derrière « nous ne connaissions pas les règles ». Anthropic les a mises par écrit.

La sécurité des consommateurs avant tout. Si Claude est en contact avec le public, la politique stricte s'applique. Enterprise bénéficie de plus d'espace, mais ne confondez pas cela avec un laissez-passer gratuit.

La sécurité de l'IA devient réalité. Ces risques ne sont plus théoriques. Cybercriminalité, ingérence électorale, armes… Anthropic affirme que les cas extrêmes sont désormais des menaces courantes.

Relier les points

Les fournisseurs de LLM commencent à prendre conscience du monde dans lequel nous vivons et à prendre position.

La mission d'Anthropic

Anthropic se positionne comme une entreprise d’IA d’intérêt public avec un objectif clair : construire des systèmes d’IA fiables, interprétables et orientables qui profitent à l’humanité à long terme.

Partage des chiffres

Parlons échelle et signal. Claude n'est plus un spécialiste :

Environ 19 millions d'utilisateurs actifs mensuels dans le monde, dont environ 2,9 millions accèdent à l'application chaque mois. Les États-Unis et l'Inde représentent à eux seuls 33,13 % de cette base.

La démographie est majoritairement jeune et masculine : environ 77 % d'hommes, les 18-24 ans représentant plus de la moitié des utilisateurs actifs. Le deuxième groupe le plus important ? Les 25-34 ans.

Dans les coulisses, Anthropic génère des centaines de millions de téléchargements d'applications et se dirige vers un chiffre d'affaires annuel de plusieurs milliards de dollars, prouvant que Claude n'est pas seulement utilisé, mais adopté.

La cybersécurité en chiffres

Le paysage des menaces alimentées par l'IA s'intensifie, et voici à quoi cela ressemble en 2025 :

85 % des responsables de la cybersécurité affirment que l’IA générative augmente directement le volume et la sophistication des cyberattaques.

142 millions de liens de phishing générés par l'IA ont été bloqués au cours du seul deuxième trimestre 2025, soit une augmentation par rapport au trimestre précédent.

Les autorités indiennes signalent que 82,6 % des e-mails de phishing utilisent désormais des outils d’IA.

Les cybercriminels exécutent 36 000 analyses automatisées par seconde, ce qui entraîne le vol de 1,7 milliard d'identifiants sur le dark web.

Les violations liées à des outils d’IA cachés ou non autorisés (également appelés « IA fantôme ») coûtent en moyenne 670 000 dollars supplémentaires aux organisations.

En résumé

Ce qui a changé :

Les lignes rouges sont explicites : pas de cyberattaques, pas d’armes, pas d’ingérence électorale.

Applications grand public = règles plus strictes.

Entreprise = plus de flexibilité, mais pas un laissez-passer gratuit.

Demandez-le :

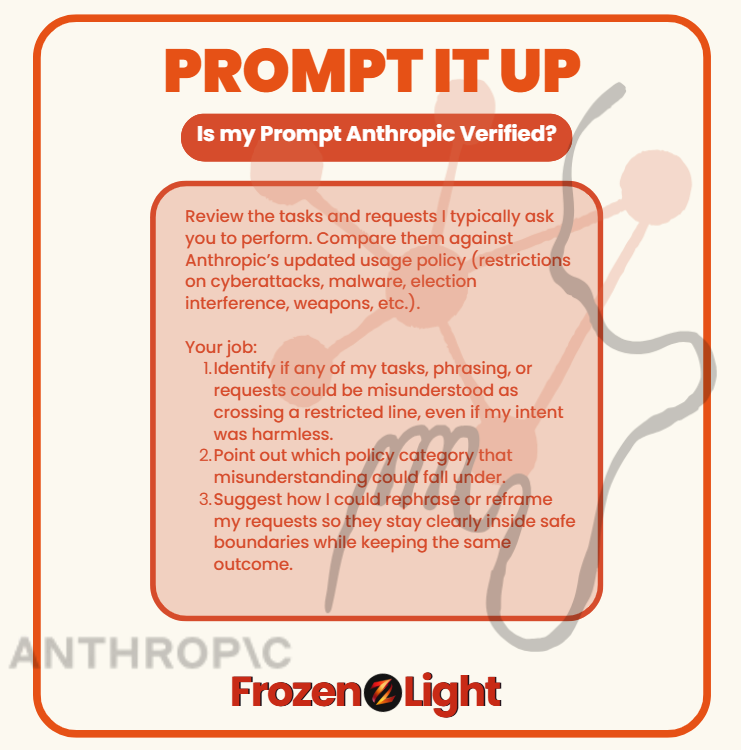

La plupart d'entre nous n'utilisent pas Claude (ni aucun autre LLM) pour créer des logiciels malveillants, pirater des élections ou fabriquer des armes. Mais avec la nouvelle politique d'Anthropic, même des tâches anodines pourraient être mal interprétées si elles sont mal formulées.

Il vaut mieux vérifier avant d’être signalé pour quelque chose que vous n’aviez pas prévu.

Copier et coller

Passez en revue les tâches et les demandes que je vous demande habituellement d'effectuer. Comparez-les à la politique d'utilisation mise à jour d'Anthropic (restrictions sur les cyberattaques, les logiciels malveillants, l'ingérence électorale, les armes, etc.).

Votre travail:

Identifiez si l’une de mes tâches, formulations ou demandes pourrait être mal interprétée comme un dépassement d’une ligne restreinte, même si mon intention était inoffensive.

Indiquez à quelle catégorie de politique ce malentendu pourrait correspondre.

Suggérez-moi comment je pourrais reformuler ou recadrer mes demandes afin qu'elles restent clairement dans des limites sûres tout en conservant le même résultat.

⚡ Exécutez ceci dans n'importe quel LLM et il vérifiera la façon dont vous demandez des choses - vous montrant si votre style pourrait ressembler à une violation de la politique, même lorsque vous ne faites rien de mal.

Point de vue de l'équipe Frozen Light

Que dire ? L'expérience compte. Plus on s'y adonne, plus on s'améliore. Rien dans la nouvelle politique d'Anthropic n'est vraiment nouveau. Ce n'est pas qu'ils ont soudainement découvert que leur LLM pouvait être utilisé à mauvais escient. Ils l'ont toujours su.

Alors que s'est-il passé maintenant ?

Dès le premier jour, la mission d'Anthropic a été « au service de l'humanité ». Ses fondateurs ont quitté OpenAI avec cette promesse sur leur drapeau. Mais si vous lisez la politique mise à jour , vous remarquerez une lacune : elle ne s'exprime plus dans le même langage axé sur le bien-être humain qu'ils utilisaient autrefois pour se définir.

Pour nous, cela ressemble à un changement qui s'acquiert avec l'expérience. On passe de l'idéalisme au réalisme. Ce n'est pas que les risques n'existaient pas auparavant ; c'est qu'Anthropic ne peut plus les ignorer désormais.

Et si vous avez suivi des masters en droit, vous connaissez ce sentiment : vous demandez quelque chose d'anodin, et soudain, le modèle refuse. Vous vous retrouvez face à un mur sans explication. Frustrant, n'est-ce pas ? Mais souvent, ce refus survient parce que votre demande semble abusive, même si votre intention était contraire.

Prenons l'exemple de la cybersécurité : s'interroger sur le fonctionnement d'une attaque peut impliquer de préparer des défenses. C'est logique. Mais pour le modèle, cela peut ressembler exactement à la planification d'une attaque. C'est la tension à laquelle Anthropic est confronté.

Alors, qu'ont-ils décidé, à notre avis ? Deux possibilités :

Option 1 : Se laver les mains. Interdire toute activité qui semble risquée, tant en attaque qu'en défense. Si c'est le cas, ce n'est pas cool. Cela rend les constructeurs aveugles.

Option 2 : Tracer des lignes plus nettes. Tirer les leçons de l'expérience, reconnaître que l'abus et la protection peuvent se ressembler, et tenter de définir la différence. Si c'est là que ça mène, tant mieux. Nous voulons que Claude participe à la défense, et pas seulement à l'évitement.

Parce que ce que nous détestons le plus, c'est quand quelque chose se produit et que nous, les constructeurs, les utilisateurs, ne sommes pas inclus dans la conversation.

Nous avons en quelque sorte le sentiment que c’est ce qui se passe ici : quelqu’un a pris une décision pour nous tous.

Et qu’il s’agisse de se laver les mains ou de tracer des lignes plus nettes, le choix ne nous appartenait pas – mais nous en subirons les conséquences.