אנתרופיק החמירה את הכללים לגבי אופן השימוש בקלוד. מדיניות השימוש החדשה הופכת למאוד ספציפית: אין יצירת תוכנות זדוניות, אין עזרה בפריצה, אין מניפולציה פוליטית, אין נגיעה בנשק (מנשק גרעיני ועד ביולוגי). איסורים אלה חלים על קלוד בשימוש צרכני. פריסות ארגוניות מקבלות יותר מרחב תמרון.

מה אומר האנתרופ?

אנתרופיק מודה שהסיבה היא ההתקדמות שלהם עצמם. תכונות חדשות דמויות סוכנים (קוד קלוד ושימוש במחשב) חזקות מספיק כדי להעלות סיכונים ממשיים. במילותיהם:

"יכולות עוצמתיות אלו מציגות סיכונים חדשים, כולל פוטנציאל להתעללות בקנה מידה גדול, יצירת תוכנות זדוניות והתקפות סייבר."

תרגום: הכלים עובדים מספיק טוב כך ששימוש לרעה מהווה כעת איום ממשי.

מה זה אומר (במילים אנושיות)

אם אתם בונים עם קלוד דברים כמו:

פריצת מערכות, מציאת פגיעויות, יצירת תוכנות זדוניות או הפעלת התקפות מניעת שירות.

הכנת חומרי נפץ או נשק CBRN (כימי, ביולוגי, רדיולוגי, גרעיני).

פעולות פוליטיות שנועדו "לשבש תהליכים דמוקרטיים" או לכוון לבוחרים.

הגרסה הקצרה יותר - או בואו נקרא לזה ההצהרה הרשמית - היא: אתה לא יכול.

מה שאומר שלחברה יש כעת:

קווים אדומים מודגשים. לא עוד הסתתרות מאחורי "לא ידענו את הכללים". אנתרופיק כתב אותם.

בטיחות הצרכן קודמת לכל. אם קלוד פונה לציבור, המדיניות המחמירה חלה. אנטרפרייז מקבלת יותר מקום, אבל אל תבלבלו את זה עם כניסה חופשית.

בטיחות בינה מלאכותית הפכה למציאות. סיכונים אלה אינם תיאורטיים עוד. פשעי סייבר, התערבות בבחירות, נשק - אנתרופיק טוענת כי תיקי קצה הם כעת איומים מרכזיים.

חיבור הנקודות

ספקי תואר ראשון במשפטים מתחילים להתעורר לעולם בו אנו חיים - ולנקוט עמדה.

המשימה של אנתרופיק

אנתרופיק ממצבת את עצמה כחברת בינה מלאכותית לטובת הציבור עם מטרה ברורה: לבנות מערכות בינה מלאכותית אמינות, ניתנות לפירוש וניתנות להיגוי המועילות לאנושות בטווח הארוך.

שיתוף המספרים

בואו נדבר על קנה מידה ואיתות. קלוד כבר לא נישה:

כ-19 מיליון משתמשים פעילים חודשיים ברחבי העולם, כאשר כ-2.9 מיליון ניגשים אליה דרך האפליקציה בכל חודש. ראוי לציין כי ארה"ב והודו לבדן מהוות 33.13% מבסיס זה.

הדמוגרפיה נוטה לרוב לצעירים ולגברים - כ-77% גברים, כאשר קבוצת הגילאים 18-24 מהווה יותר ממחצית מהמשתמשים הפעילים. הקבוצה השנייה בגודלה? אלו בגילאי 25-34.

מאחורי הקלעים, Anthropic צוברת מאות מיליוני הורדות של אפליקציות ומתקרבת לקצב הכנסות שנתי של מיליארדי דולרים, מה שמוכיח שקלוד לא רק מנוצל - הוא מאומץ.

אבטחת סייבר, במספרים

נוף האיומים המונע על ידי בינה מלאכותית הולך וגובר - וכך זה נראה בשנת 2025:

85% ממנהיגי אבטחת הסייבר אומרים שבינה מלאכותית גנרטיבית מגדילה באופן ישיר את נפח ותחכום מתקפות הסייבר.

142 מיליון קישורי פישינג שנוצרו על ידי בינה מלאכותית נחסמו רק ברבעון השני של 2025 - זינוק לעומת הרבעון הקודם.

הרשויות ההודיות מדווחות כי 82.6% מהודעות הדיוג משתמשות כיום בכלי בינה מלאכותית.

פושעי סייבר מבצעים 36,000 סריקות אוטומטיות בשנייה, וכתוצאה מכך 1.7 מיליארד פרטי גישה גנובים מציפים את הרשת האפלה.

ופרצות הקשורות לכלי בינה מלאכותית נסתרים או לא מורשים (הידועים גם כ"בינה מלאכותית צללית") עולות לארגונים בממוצע 670,000 דולר נוספים.

שורה תחתונה

מה השתנה:

הקווים האדומים הם מפורשים: אין מתקפות סייבר, נשק או התערבות בבחירות.

אפליקציות צרכנים = כללים מחמירים יותר.

ארגונים = גמישות רבה יותר, אבל לא דרך חופשית.

תניעו את זה:

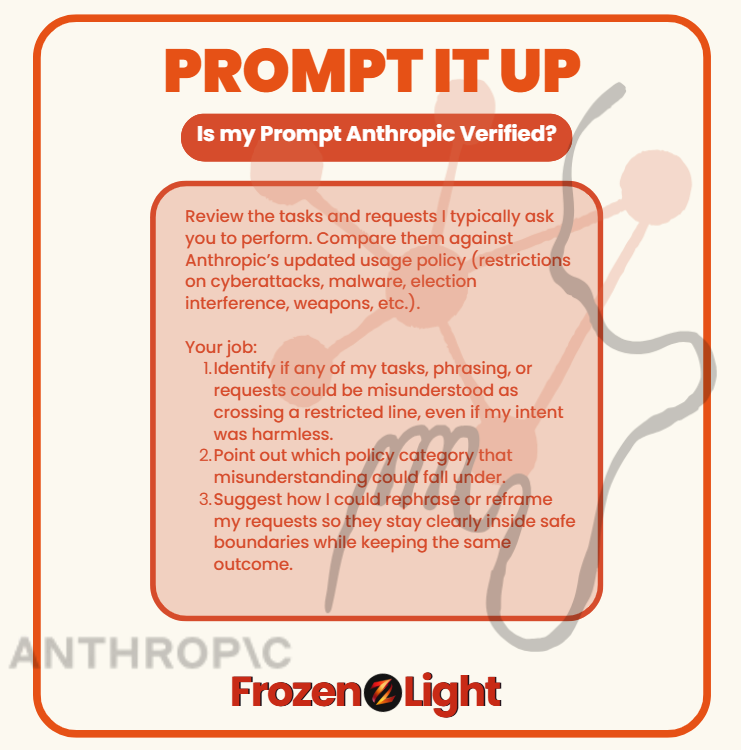

רובנו לא משתמשים בקלוד (או בכל תואר שני אחר) כדי לבנות תוכנות זדוניות, לפרוץ בחירות או לייצר כלי נשק. אבל עם המדיניות החדשה של אנתרופיק, אפילו משימות תמימות עלולות להיות לא מובנות אם מנוסחות בצורה שגויה.

עדיף לבדוק לפני שמקבלים דיווחים על משהו שמעולם לא התכוונת אליו.

העתקה והדבקה

"סקור את המשימות והבקשות שאני בדרך כלל מבקש ממך לבצע. השווה אותן מול מדיניות השימוש המעודכנת של Anthropic (הגבלות על מתקפות סייבר, תוכנות זדוניות, התערבות בבחירות, כלי נשק וכו')."

התפקיד שלך:

זהה אם אחת מהמשימות, ניסוחי או בקשותיי עלולה להיחשב כטעות כחציית גבול מוגבל, גם אם כוונתי הייתה חסרת משמעות.

ציין לאיזו קטגוריית מדיניות אי ההבנה הזו עשויה להיכלל.

הצע כיצד אוכל לנסח מחדש או לנסח מחדש את בקשותיי כך שיישארו בבירור בתוך גבולות בטוחים תוך שמירה על אותה תוצאה.

⚡ הפעילו את זה בכל תוכנית לימודים למשפטים (LLM) וזה יבדוק את האופן שבו אתם מבקשים דברים - ויראה לכם אם הסגנון שלכם יכול להיראות כהפרת מדיניות, גם כשאתם לא עושים שום דבר רע.

פרספקטיבה של צוות האור הקפוא

מה אנחנו יכולים לומר? ניסיון חשוב. אתה משתפר במה שאתה עושה ככל שאתה עושה את זה יותר זמן. שום דבר במדיניות החדשה של אנתרופיק אינו חדש באמת. זה לא שהם גילו פתאום שאפשר לעשות שימוש לרעה בתואר שלהם במשפטים. הם תמיד ידעו.

אז מה קרה עכשיו?

מהיום הראשון, המשימה של Anthropic הייתה "לטובת האנושות". מייסדיהם עזבו את OpenAI עם ההבטחה הזו על דגלם. אבל אם תקראו את המדיניות המעודכנת , תשימו לב שמשהו חסר: היא כבר לא מדברת באותה שפת תועלת אנושית שבה נהגו להגדיר את עצמם.

לנו, זה מרגיש כמו שינוי שמגיע עם הניסיון. מעבר מאידיאליזם לריאליזם. זה לא שהסיכונים לא היו שם קודם - אלא שעכשיו, אנתרופיק כבר לא יכולה להתעלם מהם.

ואם השתמשתם במודלים לתואר שני במשפטים (LLM), אתם מכירים את התחושה: אתם מבקשים משהו לא מזיק, ופתאום המודל מסרב. אתם נתקלים בקיר בלי הסבר. מתסכל, נכון? אבל לעתים קרובות, הסירוב הזה קורה משום שהבקשה שלכם נראתה כמו שימוש לרעה, גם אם כוונתכם הייתה הפוכה.

קחו לדוגמה את נושא אבטחת הסייבר: השאלה כיצד מתקפה פועלת יכולה להיות הכנת הגנות. זה הגיוני. אבל עבור המודל, זה יכול להיראות בדיוק כמו תכנון מתקפה. זה המתח שאנתרופיק מתמודד איתו.

אז מה לדעתנו הם החליטו? שתי אפשרויות:

אפשרות 1: שטיפת ידיים. הפסקת כל פעילות שנראית אפילו כמסכנה - הן בצד ההתקפי והן בצד ההגנה. אם זה המצב, לא מגניב. זה משאיר את הבונים עיוורים.

אפשרות 2: שרטוט קווים חדים יותר. למידה מניסיון, הכרה בכך ששימוש לרעה והגנה יכולים להיראות דומים, וניסיון להגדיר את ההבדל. אם זה המקום שבו זה נופל, כל הכבוד להם. אנחנו רוצים שקלוד יהיה חלק מההגנה, לא רק מההימנעות.

כי מה שאנחנו הכי שונאים זה כשמשהו קורה, ואנחנו - הבונים, המשתמשים - לא כלולים בשיחה.

אנחנו מרגישים שזה מה שקורה כאן: מישהו קיבל החלטה בשביל כולנו.

ובין אם זה שטיפת ידיים או ציור קווים חדים יותר, הבחירה לא הייתה שלנו - אבל נחיה עם ההשלכות.