Anthropic ha appena inasprito le regole sull'utilizzo di Claude. La nuova policy di utilizzo è molto specifica: divieto di generazione di malware, divieto di supporto agli hacker, divieto di manipolazione politica, divieto di toccare armi (dalle armi nucleari a quelle biologiche). Questi divieti si applicano a Claude nell'uso rivolto ai consumatori. Le distribuzioni aziendali hanno più margine di manovra.

Cosa dice Anthropic?

Anthropic ammette che il motivo risiede nel loro stesso progresso. Le nuove funzionalità simili ad agenti (Claude Code e Computer Use) sono abbastanza potenti da comportare rischi reali. Nelle loro parole:

“Queste potenti capacità introducono nuovi rischi, tra cui il potenziale di abuso su larga scala, creazione di malware e attacchi informatici”.

Traduzione: gli strumenti funzionano così bene che un uso improprio è ormai una minaccia reale.

Cosa significa (in parole umane)

Se stai lavorando con Claude per cose come:

Hackerare i sistemi, individuare vulnerabilità, creare malware o eseguire attacchi denial-of-service.

Preparazione di esplosivi o armi CBRN (chimiche, biologiche, radiologiche, nucleari).

Operazioni politiche progettate per “interrompere i processi democratici” o prendere di mira gli elettori.

La versione più breve, o meglio, la dichiarazione ufficiale, è: non puoi.

Ciò significa che ora l'azienda ha:

Linee rosse in grassetto. Non ci si nasconde più dietro il "non conoscevamo le regole". Anthropic le ha messe per iscritto.

La sicurezza del consumatore prima di tutto. Se Claude è un negozio aperto al pubblico, si applica la politica rigorosa. Enterprise ottiene più spazio, ma non confondetelo con un lasciapassare.

La sicurezza dell'intelligenza artificiale diventa realtà. Questi rischi non sono più teorici. Criminalità informatica, ingerenze elettorali, armi: Anthropic afferma che i casi limite sono ormai minacce diffuse.

Collegare i puntini

I fornitori di LLM stanno iniziando a rendersi conto del mondo in cui viviamo e a prendere posizione.

La missione di Anthropic

Anthropic si posiziona come un'azienda di intelligenza artificiale di pubblica utilità con una chiara stella polare: costruire sistemi di intelligenza artificiale affidabili, interpretabili e gestibili che possano apportare benefici all'umanità nel lungo periodo.

Condividere i numeri

Parliamo di scala e segnale. Claude non è più una nicchia:

Circa 19 milioni di utenti attivi mensilmente in tutto il mondo, di cui circa 2,9 milioni accedono tramite l'app ogni mese. In particolare, Stati Uniti e India da soli rappresentano il 33,13% di questa base.

La demografia è prevalentemente composta da giovani e uomini: circa il 77% è di sesso maschile, con la fascia di età 18-24 anni che rappresenta oltre la metà degli utenti attivi. La fascia successiva più numerosa? Quella tra i 25 e i 34 anni.

Dietro le quinte, Anthropic sta ottenendo centinaia di milioni di download di app e si sta dirigendo verso un fatturato annuo di miliardi di dollari, dimostrando che Claude non viene solo utilizzato, ma anche adottato.

La sicurezza informatica in numeri

Il panorama delle minacce basate sull'intelligenza artificiale è in continua espansione: ecco come si prospetta nel 2025:

L'85% dei responsabili della sicurezza informatica afferma che l'intelligenza artificiale generativa sta aumentando direttamente il volume e la sofisticatezza degli attacchi informatici.

Solo nel secondo trimestre del 2025 sono stati bloccati 142 milioni di link di phishing generati dall'intelligenza artificiale, un aumento notevole rispetto al trimestre precedente.

Le autorità indiane segnalano che l'82,6% delle e-mail di phishing sfrutta ormai strumenti di intelligenza artificiale.

I criminali informatici eseguono 36.000 scansioni automatiche al secondo, con il risultato che 1,7 miliardi di credenziali rubate inondano il dark web.

E le violazioni legate a strumenti di intelligenza artificiale nascosti o non autorizzati (noti anche come "intelligenza artificiale ombra") costano in media alle organizzazioni 670.000 dollari in più.

Conclusione

Cosa è cambiato:

Le linee rosse sono esplicite: niente attacchi informatici, armi o interferenze elettorali.

App per i consumatori = regole più severe.

Impresa = maggiore flessibilità, ma non un lasciapassare.

Chiedilo:

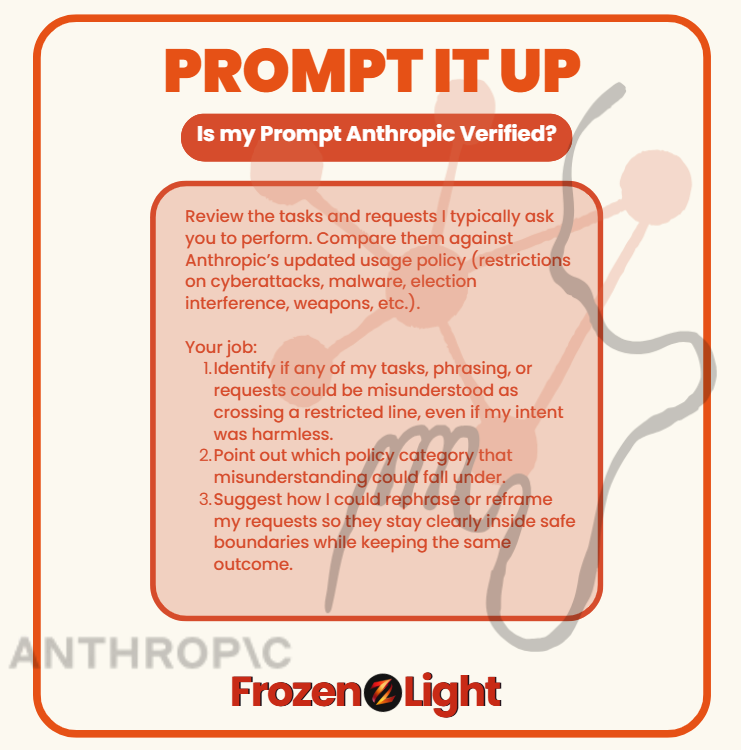

La maggior parte di noi non usa Claude (o qualsiasi altro LLM) per creare malware, hackerare elezioni o fabbricare armi. Ma con la nuova politica di Anthropic, anche compiti innocenti potrebbero essere fraintesi se formulati nel modo sbagliato.

Meglio controllare prima di essere segnalati per qualcosa che non avevi intenzione di fare.

Copia e incolla

"Esamina le attività e le richieste che solitamente ti chiedo di svolgere. Confrontale con la politica di utilizzo aggiornata di Anthropic (restrizioni su attacchi informatici, malware, interferenze elettorali, armi, ecc.).

Il tuo lavoro:

Identificare se uno qualsiasi dei miei compiti, delle mie formulazioni o delle mie richieste potrebbe essere frainteso come un superamento di un limite, anche se le mie intenzioni fossero innocue.

Indica in quale categoria di politica potrebbe rientrare tale malinteso.

Suggeriscimi come potrei riformulare o riformulare le mie richieste in modo che rimangano chiaramente entro limiti sicuri, mantenendo al contempo lo stesso risultato."

⚡ Esegui questo test in qualsiasi LLM e verificherà come chiedi le cose, mostrandoti se il tuo stile potrebbe sembrare una violazione delle norme, anche quando non stai facendo nulla di sbagliato.

Prospettiva del team di Frozen Light

Cosa possiamo dire? L'esperienza conta. Più tempo si dedica a ciò che si fa, più si migliora. Niente nella nuova politica di Anthropic è veramente nuovo. Non è che abbiano scoperto all'improvviso che il loro LLM poteva essere utilizzato impropriamente. Lo hanno sempre saputo.

E adesso cosa è successo?

Fin dal primo giorno, la missione di Anthropic è stata "per il bene dell'umanità". I suoi fondatori hanno lasciato OpenAI con questa promessa sulla bandiera. Ma se leggete la policy aggiornata , noterete che manca qualcosa: non parla più con lo stesso linguaggio a beneficio dell'umanità con cui si definivano in passato.

Per noi, questo è un cambiamento che arriva con l'esperienza. Un passaggio dall'idealismo al realismo. Non è che i rischi non ci fossero prima, è che ora Anthropic non può più ignorarli.

E se hai usato gli LLM, conosci la sensazione: chiedi qualcosa di innocuo e all'improvviso il modello rifiuta. Ti scontri con un muro senza alcuna spiegazione. Frustrante, vero? Ma spesso quel rifiuto avviene perché la tua richiesta sembrava un abuso, anche se le tue intenzioni erano opposte.

Prendiamo la sicurezza informatica: chiedersi come funziona un attacco può significare preparare le difese. Ha senso. Ma per il modello, può sembrare esattamente come pianificare un attacco. Questa è la tensione che Anthropic sta affrontando.

Quindi cosa pensiamo abbiano deciso? Due possibilità:

Opzione 1: Lavarsi le mani. Interrompere ogni attività che anche solo sembri rischiosa, sia in attacco che in difesa. Se così fosse, non sarebbe bello. Questo lascerebbe i costruttori ciechi.

Opzione 2: Tracciare linee più nette. Imparare dall'esperienza, riconoscere che l'abuso e la protezione possono sembrare simili e cercare di definire la differenza. Se è questo il punto, ben venga. Vogliamo che Claude faccia parte della difesa, non solo dell'elusione.

Perché ciò che odiamo di più è quando succede qualcosa e noi, i costruttori, gli utenti, non veniamo coinvolti nella conversazione.

In un certo senso, sentiamo che è questo che sta succedendo qui: qualcuno ha preso una decisione per tutti noi.

Che si tratti di lavarsi le mani o di tracciare linee più nette, la scelta non è stata nostra, ma dovremo convivere con le conseguenze.