Anthropic vient d'empêcher OpenAI d'utiliser l' API Claude - y compris Claude Code.

Pourquoi?

Parce qu’ils pensent qu’OpenAI a enfreint les règles.

OpenAI a eu accès à Claude et l'a utilisé dans ses outils de test internes.

Ils comparaient Claude à leurs propres modèles, et l’utilisaient peut-être même pour améliorer GPT-5.

Anthropic n'a pas aimé ça.

Leurs conditions stipulent que vous ne pouvez pas utiliser Claude pour construire ou entraîner un modèle concurrent.

Ils ont donc coupé OpenAI.

Juste avant le lancement de GPT‑5 .

Ce que disent les entreprises

Anthropic affirme qu'OpenAI a enfreint les règles.

Ils ne permettent pas aux gens d'utiliser Claude pour former ou améliorer des modèles concurrents - surtout pas à cette échelle.

Ils ont dit :

« On accepte les comparaisons superficielles. Mais utiliser Claude pour améliorer son propre modèle ? C'est interdit. »

OpenAI n'est pas content.

Ils ont déclaré qu'ils étaient « déçus » et ont souligné qu'Anthropic avait toujours accès à l'API d'OpenAI.

Ils ont également dit :

« L’analyse comparative des concurrents est une pratique courante. »

Mais ils n’ont pas précisé s’ils avaient réellement utilisé Claude pour entraîner GPT-5.

Ce que cela signifie (en termes humains)

OpenAI a eu accès à l'API de Claude.

Ils l'ont branché sur leurs outils internes et l'ont testé avec leurs propres modèles - probablement pour voir comment Claude gérait des choses comme le code, les invites de sécurité et le raisonnement.

Anthropic a considéré cela comme un dépassement de limite.

Leurs conditions stipulent que vous ne pouvez pas utiliser Claude pour construire ou entraîner un modèle concurrent.

Alors ils ont fermé la porte.

Il ne s’agit pas seulement d’OpenAI contre Anthropic.

Si vous donnez accès à l'API à votre logiciel, cela est important.

Vous faites confiance aux gens non seulement pour l’utiliser, mais aussi pour ne pas en tirer des leçons qui pourraient vous blesser.

Relier les points

Est-ce vraiment une nouvelle ?

Regardons les faits.

Que disent réellement les conditions générales d'Anthropic ?

Conformément aux conditions générales de service commerciales d'Anthropic, les clients ne sont pas autorisés à :

« Utiliser les Services pour créer un produit ou un service concurrent, notamment pour former des modèles d'IA concurrents. »

« Rétro-ingénierie ou duplication des Services. »

Cette clause est la raison pour laquelle Anthropic affirme avoir révoqué l'accès à l'API d'OpenAI.

Source : WIRED – juillet 2025

Quel est le but de donner à quelqu’un l’accès à l’API ?

Une API (interface de programmation d'application) permet à d'autres produits ou services d'interagir avec un modèle à grande échelle, grâce à l'automatisation.

Lorsque les entreprises donnent accès à l'API, c'est généralement :

Pour intégrer l'IA dans des outils, des applications ou des flux de travail

Pour exécuter des tâches à grande échelle telles que le résumé, le codage ou la classification

Permettre aux développeurs de tester et de créer de nouvelles fonctionnalités en utilisant les capacités du modèle d'IA

L'utilisation des API n'est presque jamais manuelle. Elle implique un accès groupé, une utilisation répétée et généralement automatisée ; c'est précisément pourquoi les entreprises définissent des règles d'utilisation.

Anthropic savait-il qu'OpenAI utilisait son API ?

Oui, et tout indique qu’il s’agit d’une décision calculée, et non d’une surprise.

OpenAI aurait dû s'inscrire pour accéder à l'API de Claude, ce qui signifie qu'Anthropic l'a accordé en toute connaissance de cause. L'utilisation de l'API est traçable, et des fournisseurs comme Anthropic surveillent qui appelle leurs modèles et comment.

Le fait que cette révocation ait eu lieu juste avant le lancement supposé de GPT-5 – et qu'elle ait été rendue publique – suggère une stratégie, et non un accident. Anthropic a également évoqué une violation de ses conditions d'utilisation, ce qui laisse penser que ce n'était pas la première préoccupation soulevée.

Ainsi, même si la déclaration publique a pu donner l'impression qu'il s'agissait d'une mesure coercitive, il est plus probable qu'il s'agissait d'une ligne délibérée tracée dans le sable - selon les conditions d'Anthropic, à un moment de son choix.

En résumé

Anthropic a révoqué l'accès API d'OpenAI à Claude début août 2025.

La raison invoquée : violation des conditions d'utilisation d'Anthropic.

Cette décision a eu lieu peu de temps avant le lancement prévu de GPT-5 d'OpenAI.

OpenAI a précédemment accusé d'autres modèles, comme DeepSeek , de s'entraîner sur ses sorties - une préoccupation croissante dans la course à l'IA.

L'accès à l'API est accordé en toute connaissance de cause ; son utilisation est traçable.

Anthropic a rendu publique cette révocation, indiquant une décision stratégique.

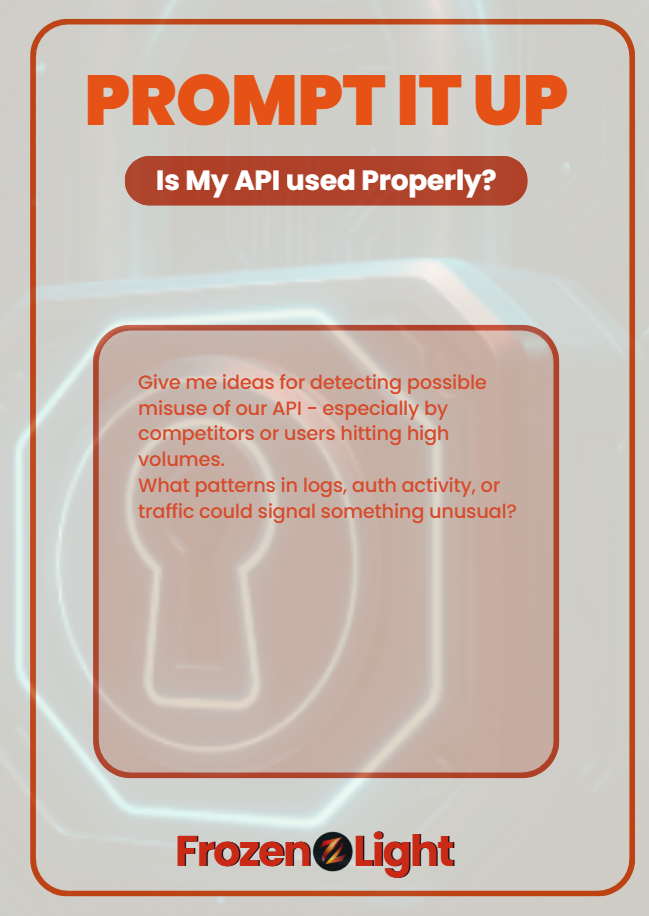

Invitez-le

Si votre application fournit une API, demandez à votre LLM :

« Donnez-moi des idées pour détecter une éventuelle utilisation abusive de notre API, en particulier par des concurrents ou des utilisateurs atteignant des volumes élevés.

« Quels modèles dans les journaux, l’activité d’authentification ou le trafic pourraient signaler quelque chose d’inhabituel ? »

Cela ne suffira pas à mettre fin aux abus,

mais cela peut vous aider à le repérer tôt et à agir rapidement.

Point de vue de l'équipe Frozen Light

Ce n'est pas une nouvelle. C'est une stratégie.

Et nous allons lancer une théorie du complot.

Il semble qu'Anthropic savait qu'OpenAI utilisait son API - ou qu'il ne voulait pas admettre qu'il ne l'avait pas fait.

Parce que dire « nous n’avons pas remarqué » serait mal vu.

Mais ils ne disent pas non plus : « Nous ne savions pas. » Ce silence dit quelque chose.

Et maintenant, juste avant le lancement prévu de ChatGPT-5, ils rendent publique une « violation des conditions » ?

Alors qu'OpenAI prétend qu'il s'agissait simplement d'un accès standard ?

On a l'impression qu'Anthropic prépare la planche de surf avant que la vague GPT-5 ne frappe.

Si ChatGPT-5 finit par être tout ce qu'il prétend être, vous savez déjà où iront les rumeurs :

Formé sur Claude ?

Code construit à l'aide des modèles d'Anthropic ?

Alors, avant même que la balade ne commence, Anthropic pagaie et plante un drapeau.

Honnêtement ? C'est une stratégie intelligente.

Et la logique derrière notre théorie est simple :

Si nous voyions un concurrent jouer avec notre Alex en utilisant une API, nous ne lui accorderions pas une seconde.

Nous les bloquerions, sans poser de questions.

Donc le fait qu'Anthropic ne l'ait pas fait ?

Ouais… bizarre.