Anthropic acaba de impedir que OpenAI utilice la API de Claude , incluido Claude Code.

¿Por qué?

Porque creen que OpenAI rompió las reglas.

OpenAI tuvo acceso a Claude y lo utilizó en sus herramientas de prueba internas.

Estaban comparando a Claude con sus propios modelos, posiblemente incluso usándolo para ayudar a mejorar GPT-5.

A Anthropic no le gustó esto.

Sus términos dicen que no puedes usar a Claude para construir o entrenar un modelo competitivo.

Así que cortaron OpenAI.

Justo antes del lanzamiento de GPT‑5 .

Lo que dicen las empresas

Anthropic dice que OpenAI rompió las reglas.

No permiten que la gente use a Claude para entrenar o mejorar modelos competitivos, especialmente no a esta escala.

Ellos han dicho:

Nos parecen bien las comparaciones casuales. ¿Pero usar a Claude para mejorar tu propio modelo? Eso no está permitido.

OpenAI no está contento.

Dijeron que estaban “decepcionados” y señalaron que Anthropic todavía tiene acceso a la API de OpenAI.

También dijeron:

“Evaluar a los competidores como referencia es una práctica habitual”.

Pero no dijeron si realmente utilizaron a Claude para entrenar a GPT-5.

Lo que eso significa (en palabras humanas)

OpenAI tuvo acceso a la API de Claude.

Lo conectaron a sus herramientas internas y lo probaron junto con sus propios modelos, probablemente para ver cómo Claude manejaba cosas como el código, las indicaciones de seguridad y el razonamiento.

Para Anthropic, esto suponía cruzar el límite.

Sus términos dicen que no puedes usar a Claude para construir o entrenar un modelo competitivo.

Entonces cerraron la puerta.

No se trata simplemente de OpenAI contra Anthropic.

Si está otorgando acceso API a su software, esto es importante.

Estás confiando en que la gente no sólo lo use, sino que también no aprenda de ello de maneras que te lastimen.

Conectando los puntos

¿Es esto siquiera noticia?

Veamos los hechos.

¿Qué dicen realmente los Términos y Condiciones de Anthropic?

De acuerdo con los Términos de servicio comerciales de Anthropic, los clientes no pueden:

“Utilizar los Servicios para crear un producto o servicio competitivo, incluido el entrenamiento de modelos de IA competitivos”.

“Realizar ingeniería inversa o duplicar los Servicios”.

Esta cláusula es la razón por la que Anthropic dice que revocó el acceso a la API de OpenAI.

Fuente: WIRED – Julio de 2025

¿Cuál es el propósito de darle acceso API a alguien?

Una API (interfaz de programación de aplicaciones) permite que otros productos o servicios interactúen con un modelo a escala, a través de la automatización.

Cuando las empresas otorgan acceso a la API, generalmente:

Para integrar la IA en herramientas, aplicaciones o flujos de trabajo

Para ejecutar tareas a gran escala como resumen, codificación o clasificación.

Permitir que los desarrolladores prueben y creen nuevas funciones utilizando las capacidades del modelo de IA

El uso de la API casi nunca es manual. Implica acceso masivo, uso repetido y, generalmente, automatización; por eso mismo, las empresas establecen normas sobre su uso.

¿Sabía Anthropic que OpenAI estaba usando su API?

Sí, y todas las señales apuntan a que se trata de una decisión calculada y no de una sorpresa.

OpenAI habría tenido que registrarse para acceder a la API de Claude, lo que significa que Anthropic lo otorgó a sabiendas. El uso de la API es rastreable, y proveedores como Anthropic monitorean quién y cómo accede a sus modelos.

El hecho de que esta revocación ocurriera justo antes del rumoreado lanzamiento de GPT-5, y se hiciera pública, sugiere una estrategia, no un accidente. Anthropic también mencionó una violación de sus Términos de Servicio, lo que sugiere que esta no fue la primera preocupación planteada.

Así, aunque la declaración pública lo hizo parecer una medida de cumplimiento, es más probable que se tratara de una línea deliberada trazada en la arena, en los términos de Anthropic, en un momento de su elección.

En resumen

Anthropic revocó el acceso a la API de OpenAI a Claude a principios de agosto de 2025.

Motivo dado: violación de los Términos de Servicio de Anthropic.

Este movimiento ocurrió poco antes del lanzamiento esperado de GPT-5 de OpenAI.

OpenAI acusó anteriormente a otros modelos, como DeepSeek , de entrenarse con sus resultados, una preocupación creciente en la carrera de la IA.

El acceso a la API se concede de forma consciente y su uso es rastreable.

Anthropic hizo pública esta revocación, indicando una decisión estratégica.

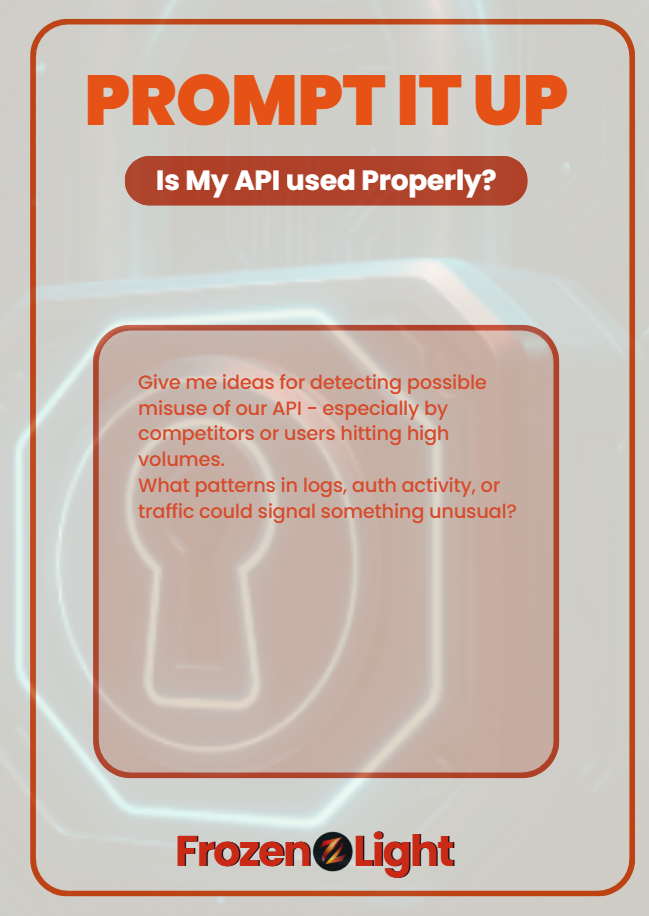

Apúntalo

Si su aplicación proporciona una API, pregúntele a su LLM:

“Deme ideas para detectar un posible uso indebido de nuestra API, especialmente por parte de competidores o usuarios con grandes volúmenes.

¿Qué patrones en los registros, la actividad de autenticación o el tráfico podrían indicar algo inusual?

No detendrá el mal uso por sí solo,

pero puede ayudarle a detectarlo a tiempo y actuar rápidamente.

Perspectiva del equipo Frozen Light

Esto no es noticia. Es estrategia.

Y vamos a lanzar una teoría de conspiración.

Parece que Anthropic sabía que OpenAI estaba usando su API, o no quiere admitir que no lo sabía.

Porque decir “no nos dimos cuenta” quedaría mal.

Pero tampoco dicen: “No lo sabíamos”. Ese silencio dice algo.

¿Y ahora, justo antes del lanzamiento previsto de ChatGPT-5, hacen pública la “violación de los términos”?

¿Mientras que OpenAI afirma que fue solo un acceso estándar?

Parece que Anthropic está preparando la tabla de surf antes de que llegue la ola GPT-5.

Si ChatGPT-5 termina siendo todo lo que dice ser, ya sabes hacia dónde irán los rumores:

¿Entrenado en Claude?

¿Código creado utilizando los modelos de Anthropic?

Entonces, antes de que comience el viaje, Anthropic sale remando y planta una bandera.

¿En serio? Es una estrategia inteligente.

Y la lógica detrás de nuestra teoría es simple:

Si viéramos a un competidor jugando con nuestro Alex usando una API, no le daríamos ni un segundo.

Los bloquearíamos, sin hacer preguntas.

¿Entonces el hecho de que Anthropic no lo hiciera?

Sí… raro.