قامت Anthropic للتو بمنع OpenAI من استخدام واجهة برمجة التطبيقات Claude - بما في ذلك Claude Code.

لماذا؟

لأنهم يعتقدون أن OpenAI خالفت القواعد.

تمكنت OpenAI من الوصول إلى Claude واستخدمته في أدوات الاختبار الداخلية الخاصة بها.

لقد قاموا بمقارنة كلود بنماذجهم الخاصة - وربما حتى استخدموها للمساعدة في تحسين GPT‑5.

لم يعجب الأنثروبي ذلك.

تقول شروطهم أنه لا يمكنك استخدام كلود لبناء أو تدريب نموذج منافس.

لذلك قاموا بقطع OpenAI.

قبل وقت قصير من إطلاق GPT‑5 .

ما تقوله الشركات

تقول شركة Anthropic أن شركة OpenAI خالفت القواعد.

إنهم لا يسمحون للناس باستخدام كلود لتدريب أو تحسين النماذج المتنافسة - خاصة ليس على هذا النطاق.

قالوا:

لا بأس بالمقارنات العفوية. لكن استخدام كلود لتحسين نموذجك الخاص؟ هذا غير مسموح به.

OpenAI ليست سعيدة.

قالوا إنهم يشعرون "بخيبة أمل" وأشاروا إلى أن Anthropic لا يزال لديه حق الوصول إلى واجهة برمجة التطبيقات الخاصة بـ OpenAI.

وقالوا أيضا:

"إن مقارنة أداء المنافسين هي ممارسة قياسية."

لكنهم لم يذكروا ما إذا كانوا قد استخدموا بالفعل كلود لتدريب GPT‑5.

ماذا يعني ذلك (بالكلمات البشرية)

تمكنت OpenAI من الوصول إلى واجهة برمجة التطبيقات الخاصة بـ Claude.

لقد قاموا بتوصيله بأدواتهم الداخلية واختباره جنبًا إلى جنب مع نماذجهم الخاصة - ربما لمعرفة كيفية تعامل كلود مع أشياء مثل الكود ومطالبات السلامة والاستدلال.

وقد رأى أنثروبيك أن هذا الأمر يمثل تجاوزًا للحدود.

تقول شروطهم أنه لا يمكنك استخدام كلود لبناء أو تدريب نموذج منافس.

فأغلقوا الباب.

لا يتعلق الأمر فقط بمنافسة OpenAI وAnthropic.

إذا كنت تمنح الوصول إلى واجهة برمجة التطبيقات (API) لبرنامجك، فهذا أمر مهم.

أنت تثق في الناس ليس فقط لاستخدامها، بل أيضًا لعدم التعلم منها بطرق تؤذيك.

ربط النقاط

هل هذا خبر حقيقي؟

دعونا ننظر إلى الحقائق.

ماذا تقول شروط وأحكام Anthropic فعليًا؟

وفقًا لشروط الخدمة التجارية الخاصة بشركة Anthropic، لا يُسمح للعملاء بما يلي:

"استخدم الخدمات لبناء منتج أو خدمة منافسة، بما في ذلك تدريب نماذج الذكاء الاصطناعي المنافسة."

"الهندسة العكسية أو تكرار الخدمات."

هذا البند هو السبب الذي جعل Anthropic تقول إنها ألغت وصول API الخاص بـ OpenAI.

المصدر: WIRED – يوليو 2025

ما هو الغرض من منح شخص ما حق الوصول إلى واجهة برمجة التطبيقات؟

تسمح واجهة برمجة التطبيقات (API) للمنتجات أو الخدمات الأخرى بالتفاعل مع نموذج على نطاق واسع - من خلال الأتمتة.

عندما تمنح الشركات حق الوصول إلى واجهة برمجة التطبيقات، يكون ذلك عادةً:

لتضمين الذكاء الاصطناعي في الأدوات أو التطبيقات أو سير العمل

لتشغيل مهام واسعة النطاق مثل التلخيص أو الترميز أو التصنيف

للسماح للمطورين باختبار وبناء ميزات جديدة باستخدام قدرات نموذج الذكاء الاصطناعي

نادرًا ما يكون استخدام واجهة برمجة التطبيقات (API) يدويًا. هذا يعني الوصول الجماعي، والاستخدام المتكرر، والأتمتة عادةً - وهذا هو بالضبط سبب وضع الشركات لقواعد حول كيفية استخدامها.

هل كانت شركة Anthropic تعلم أن شركة OpenAI تستخدم واجهة برمجة التطبيقات الخاصة بها؟

نعم - وكل الدلائل تشير إلى أن هذه خطوة مدروسة، وليست مفاجئة.

كان على OpenAI التسجيل للحصول على حق الوصول إلى واجهة برمجة التطبيقات (API) الخاصة بـ Claude، مما يعني أن Anthropic منحته ذلك عن علم. استخدام واجهة برمجة التطبيقات (API) قابل للتتبع، ويراقب مزودو الخدمات مثل Anthropic من يتصل بنماذجهم وكيف.

إن حقيقة أن هذا الإلغاء حدث مباشرةً قبل إطلاق GPT-5 المزعوم - وتم الإعلان عنه - تشير إلى استراتيجية، وليس صدفة. كما أشارت شركة Anthropic إلى انتهاك لشروط الخدمة الخاصة بها، مما يُشير إلى أن هذا لم يكن أول قلق يُثار.

وعلى الرغم من أن البيان العام جعل الأمر يبدو وكأنه عملية إنفاذ، فمن المرجح أن يكون هذا خطًا متعمدًا تم رسمه في الرمال - وفقًا لشروط أنثروبيك، في اللحظة التي اختارتها.

خلاصة القول

قامت Anthropic بإلغاء وصول API الخاص بـ OpenAI إلى Claude في أوائل أغسطس 2025.

السبب المذكور: انتهاك شروط خدمة Anthropic.

حدثت هذه الخطوة قبل وقت قصير من إطلاق OpenAI لمنتج GPT-5 المتوقع.

اتهمت شركة OpenAI في السابق نماذج أخرى، مثل DeepSeek ، بالتدريب على مخرجاتها - وهو ما يمثل مصدر قلق متزايد في سباق الذكاء الاصطناعي.

يتم منح حق الوصول إلى واجهة برمجة التطبيقات (API) عن علم؛ ويمكن تتبع الاستخدام.

وأعلنت شركة أنثروبيك عن هذا الإلغاء علنًا، مما يشير إلى قرار استراتيجي.

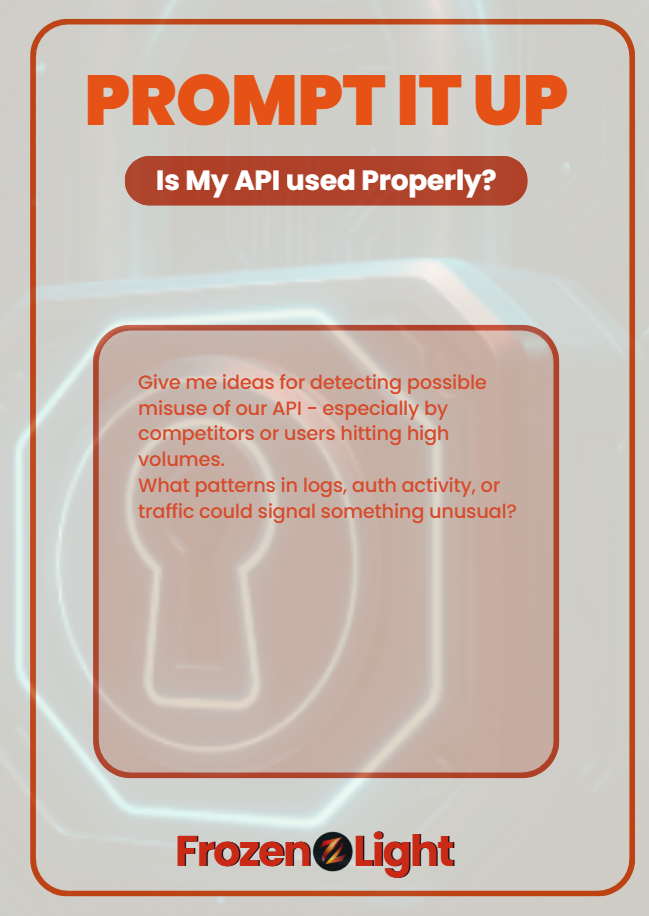

اطرحها

إذا كان تطبيقك يوفر واجهة برمجة التطبيقات، فاسأل أستاذك في القانون:

"أعطوني أفكارًا لاكتشاف سوء الاستخدام المحتمل لواجهة برمجة التطبيقات الخاصة بنا - وخاصةً من قِبل المنافسين أو المستخدمين الذين يصلون إلى أحجام كبيرة.

ما هي الأنماط الموجودة في السجلات أو نشاط المصادقة أو حركة المرور التي يمكن أن تشير إلى شيء غير عادي؟"

لن يتوقف سوء الاستخدام من تلقاء نفسه،

لكنها قد تساعدك على اكتشافه مبكرًا والتصرف بسرعة.

منظور فريق الضوء المتجمد

هذا ليس خبرًا، هذه استراتيجية.

وسنطرح نظرية المؤامرة هناك.

يبدو أن Anthropic إما كانت تعلم أن OpenAI كانت تستخدم واجهة برمجة التطبيقات الخاصة بها - أو أنها لا تريد الاعتراف بعدم معرفتها بذلك.

لأن القول "لم نلاحظ" سيبدو سيئًا.

لكنهم لا يقولون أيضًا: "لم نكن نعلم". هذا الصمت يقول شيئًا ما.

والآن، قبل الموعد المتوقع لإطلاق ChatGPT-5، أعلنوا علنًا عن "انتهاك الشروط"؟

في حين تدعي OpenAI أن الأمر كان مجرد وصول قياسي؟

يبدو أن Anthropic يجهز لوح التزلج قبل وصول موجة GPT-5.

إذا انتهى الأمر بـ ChatGPT-5 إلى أنه كل ما يدعيه، فأنت تعلم بالفعل إلى أين ستذهب الشائعات:

تدرب على كلود؟

تم بناء الكود باستخدام نماذج Anthropic؟

لذلك قبل أن تبدأ الرحلة، يخرج أنثروبيك ويزرع العلم.

بصراحة؟ هذه استراتيجية ذكية.

والمنطق وراء نظريتنا بسيط:

إذا رأينا أحد المنافسين يتلاعب بـ Alex الخاص بنا باستخدام واجهة برمجة التطبيقات، فلن نعطيه فرصة ثانية.

سنقوم بحظرهم - دون طرح أي أسئلة.

إذن الحقيقة هي أن أنثروبيك لم يفعل ذلك؟

نعم... غريب.