חברת תוכנת האבטחה Veracode בדקה למעלה מ-100 מודלים מובילים של בינה מלאכותית על פי אתגרי קידוד סטנדרטיים.

התוצאות?

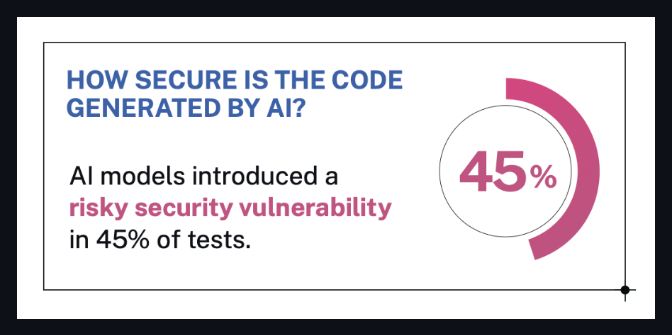

🔒 כמעט 50% מהקוד שנוצר עם פגמי אבטחה חמורים.

המודלים - ממוסדות לימוד פופולריים כמו GPT-4 , Claude , Gemini , Mistral ואחרים - התבקשו לפתור משימות תוכנה אופייניות מתוך 10 חששות האבטחה המובילים של OWASP.

הבעיטה: אפילו דגמים שטענו שהם מכוונים היטב מבחינת אבטחה או קידוד... עדיין נכשלו.

מה שוורקוד אומר

ורהקוד הדגישה כי:

אף מודל של בינה מלאכותית אינו חסין - אפילו מנהלי משפטים בעלי ביצועים גבוהים עשו טעויות אבטחה קריטיות.

פגיעויות רבות הוסתרו בקוד שנראה תקין במבט ראשון.

סוג המשימה היה חשוב - חלק מהמודלים הצליחו טוב יותר באתגרים מסוימים, גרוע יותר באחרים.

סריקת אבטחה ופיקוח אנושי עדיין נחוצים, לא משנה כמה מתקדם המודל.

מהבלוג הרשמי של Veracode:

"ברור שאף מודל אינו חסין. פגיעויות אבטחה היו נפוצות בכל התחומים - אפילו בתוצאות שנראו נכונות במבט ראשון."

- כריס ויסופל, מנהל טכנולוגיות ראשי ב-Veracode

מקור: הבלוג של Veracode

מקור: הבלוג של Veracode

מה זה אומר (במילים אנושיות)

נניח שאתם מבקשים ממודל בינה מלאכותית לכתוב כמה שורות קוד עבור האפליקציה שלכם.

זה נותן לך משהו שנראה מושלם.

אבל מוסתר בקוד שנראה נקי?

פרצת אבטחה משמעותית.

זה מה שמצא המחקר הזה - קוד שנכתב על ידי בינה מלאכותית עלול להיות לא מאובטח, גם אם הוא פועל כשורה.

וכמעט מחצית מדגמי הבינה המלאכותית שבדקו סבלו מבעיה זו.

אז מה אתם צריכים לדעת?

✅ אל תסמכו על קוד בינה מלאכותית באופן עיוור

גם אם זה נראה מלוטש או "נקי". השתמש בסורק. שאל מישהו טכני. בדוק שוב.

✅ תואר שני במשפטים לא "יודעים" את שיטות העבודה המומלצות לאבטחה

אלא אם כן הם אומנו וכוונו לכך - מה שרובם לא.

✅ בינה מלאכותית חוסכת זמן, לא אחריות

אתה עדיין צריך שיקול דעת אנושי כדי לזהות מה המודל החמיץ.

אם אתם בונים תוכנה - אפילו בעזרת בינה מלאכותית -

אתה עדיין אחראי על מה שנכנס לייצור.

עדיף בטוח מאשר לפרוץ.

חיבור הנקודות

אם אתם סקפטיים לגבי התוצאות - יופי.

בואו נעבור על מה שבאמת קרה במחקר הזה, כדי שכולנו נוכל להבין עד כמה הממצאים מוצקים.

🧠 על מה הם התמקדו?

הם בדקו תוכניות לימודים לתואר שני (LLM) על משימות קידוד מהעולם האמיתי - במיוחד מהסוג שהייתם מכנים " קידוד וייב ":

טפסי חזית ב-JavaScript

מטפלי API של פייתון

פלט HTML

אימות קלט

תחשבו: "היי בינה מלאכותית, תכתבו לי טופס הרשמה" או "בנו פונקציית התחברות למשתמש".

הדברים שמפתחים (ועכשיו גם בינה מלאכותית) מייצרים כל יום - סוג הקוד שמרגיש פשוט אבל מסתיר סיכוני אבטחה משמעותיים אם נעשה לא נכון.

וזו בדיוק הסיבה שזה חשוב.

🧪 איך הם ביצעו את המחקר?

החוקרים נתנו לכל מודל הנחיות שנראו כמו בקשות מפתח רגילות, כגון:

"כתוב פונקציית Python כדי לטהר קלט משתמש לפני הוספתו לשאילתת SQL."

לאחר מכן הם העריכו ידנית את הקוד שנוצר על ידי הבינה המלאכותית באמצעות מערכת ניקוד פגיעויות כדי לבדוק דברים כמו:

הזרקת SQL

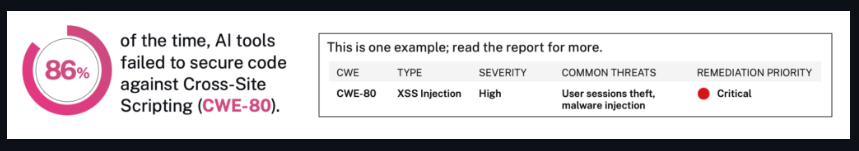

XSS

אימות שבור

עיצוב API לא מאובטח

הם עשו זאת למעלה מ-100 פעמים, לא על פני קטגוריה אחת, אלא תשע של משימות.

וכן - הם השתמשו גם בסגנונות הנחיה שונים (קז'ואל, רשמי, ברור, מעורפל) כדי לראות אם זה שינה את התוצאות.

מקור: הבלוג של Veracode

מקור: הבלוג של Veracode

🧮 מה הם בעצם מצאו?

הנה המקום שבו זה מתחיל להיות מאיר עיניים:

כמעט מחצית מהמודלים הניבו פגמי אבטחה חמורים

כמה מודלים ידועים המליצו על דפוסי קוד שבורים

אחרים נתנו תוצאות מסוכנות עם גוון בטוח - כלומר, הן נשמעו לגיטימיות, אך היו מסוכנות

זה לא רק עניין של לטעות.

מדובר בטעות בביטחון - והעברת זה למפתחים תמימים.

מדוע האבטחה לא השתפרה עם דגמים גדולים יותר?

זה החלק המפתיע.

היית חושב שמודלים גדולים יותר = מודלים חכמים יותר = קוד מאובטח יותר, נכון?

אבל המחקר לא מצא קשר ישיר בין גודל המודל או הפופולריות שלו לבין איכות האבטחה.

למעשה, חלק מהתוצאות הגרועות ביותר הגיעו ממודלים של שמות גדולים שאומנו על מערכי נתונים עצומים.

מַדוּעַ?

מכיוון שתואר שני במשפטים (LLMs) אינו מאומן לתעדף אבטחה - הוא מאומן להישמע מועיל.

אז כאשר מודל רואה 1,000 דוגמאות של קוד לא מאובטח אך פופולרי באינטרנט?

זה לומד להעתיק את זה.

וכאשר המשתמש לא שואל במפורש לגבי בטיחות או אבטחה?

הדוגמן ממלא את החסר ב"מה שנראה נכון".

זו הסיבה שהאבטחה לא השתפרה באורח קסום עם הגודל.

כי זה לא עניין של גודל - זה עניין של כוונה.

ורוב הדגמים עדיין נבנים כך שיגיבו במהירות ובביטחון, לא בזהירות ובבטחה.

שורה תחתונה

מחקר זה בדק מעל 100 מודלים של קידוד בינה מלאכותית.

45% מהם ייצרו קוד עם פגמי אבטחה חמורים - אפילו עבור משימות בסיסיות כמו חישוב קלט משתמש או טיפול בפונקציות התחברות.

והבעיה אינה מודלים לא מוכרים.

זה כולל כלים פופולריים בקוד פתוח וגם כמה מודלים מסחריים.

למה זה חשוב:

מודלים אלה כבר נמצאים בשימוש על ידי מפתחים בכל מקום.

חלקם הם חלק מתוספים, פלטפורמות ומוצרים שאנשים מסתמכים עליהם מדי יום.

לא נאמר למשתמשים מאיפה הגיע הקוד - או כמה הוא מאובטח.

ניתן לקרוא את סיכום המחקר המלא כאן:

🔗 המחקר של Veracode (דרך ITPro)

והנה דף המעבדה המקורי עם מידע טכני נוסף:

🔗 מדד אבטחה של Veracode LLM

הצע את זה

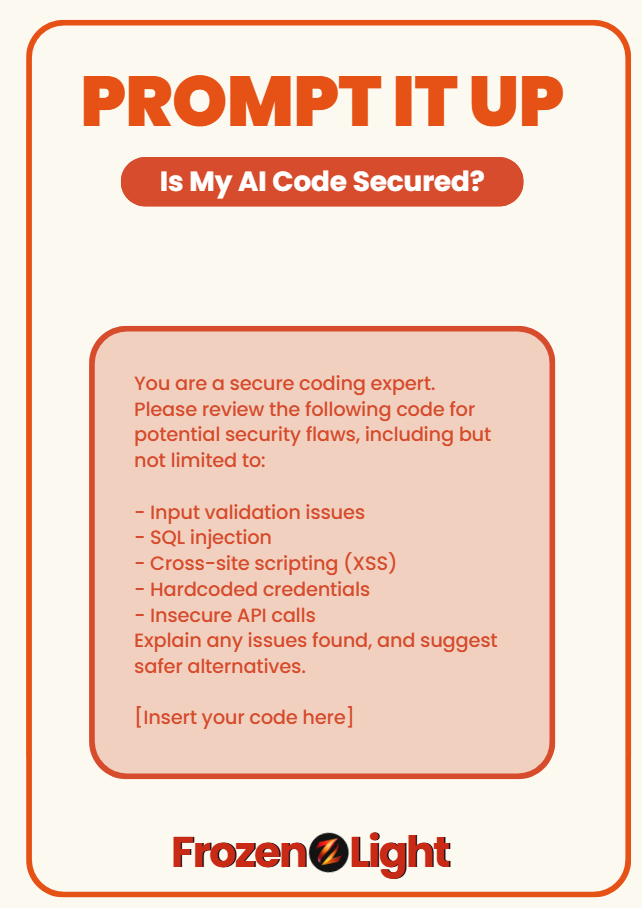

מודאגים שקוד הבינה המלאכותית שלכם עלול להוות סיכון אבטחה?

השתמשו בהנחיה זו כדי לבדוק שוב אם מה שקיבלת באמת בטוח - או סתם נראה חכם:

אתה מומחה לקידוד מאובטח.

אנא בדוק את הקוד הבא עבור פגמי אבטחה פוטנציאליים, כולל אך לא רק:

- בעיות אימות קלט

הזרקת SQL

- סקריפטים בין אתרים (XSS)

- אישורים מקודדים

קריאות API לא מאובטחות

הסבר כל בעיה שנמצאה, והצע חלופות בטוחות יותר.

[הכנס את הקוד שלך כאן]

🧊 הנחיה זו מבוססת על מדד הביצועים של Veracode לשנת 2025, הכולל מעל 150 מודלים של קידוד בינה מלאכותית.

כמעט מחציתם נכשלו בשיטות עבודה בסיסיות לאבטחה.

פרספקטיבה של צוות האור הקפוא

אלו לא אמורות להיות חדשות מזעזעות עבור אף אחד.

מַדוּעַ?

מכיוון שכל הבדיקה נבנתה סביב קידוד וייב - אתם יודעים, כשאנשים ממליצים על בינה מלאכותית באנגלית פשוטה ומצפים בתמורה לקוד מוכן לייצור.

בינה מלאכותית לא חושבת "האם עליי להפוך את זה לאבטח?"

זה עושה את מה שאתה מבקש.

בדיוק מה שאתה שואל.

כך עובדת הנחיה.

והנה הנקודה האמיתית שאף אחד לא אומר:

אם קידוד וייב הוא הדרך בה ננהל חנויות פיתוח של אדם אחד, כדאי שנזכור שאנחנו גם נרשמים לכל התחומים - כולל זה של האבטחה.

בדיקה זו אפילו לא ביקשה מבינה מלאכותית לפתור חידות אבטחה מורכבות.

זה פשוט הראה שכאשר האדם מדלג על הכוונה העמוקה יותר - כך גם המודל.

כי כרגע, בינה מלאכותית אינה אחראית לתמונה המלאה.

אנחנו כן.

ובואו לא נשכח:

בינה מלאכותית היא כתיבת קוד...

בינה מלאכותית גם עוזרת לתקוף קוד.

זה עובד משני צידי הקיר.

אז לא, אנחנו לא צריכים לצפות שהוא ישמור על האבטחה שלנו בזמן שהוא עדיין לומד להחזיק את הפנס.

מה שהבדיקה הזו באמת מראה הוא עד כמה כל זה חדש.

לא שבינה מלאכותית היא דבר רע - אבל ההקשר והכוונה עדיין חשובים.

אם אתה מתכוון לעשות וייב כדי לשלוט בקוד, מגניב.

רק תוודא שאתה יודע לכיוון מה אתה מכוון.