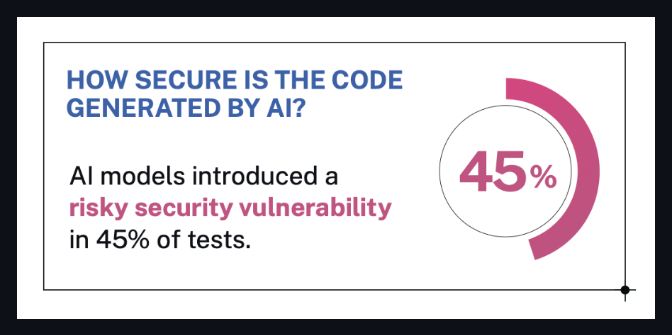

قامت شركة برامج الأمان Veracode باختبار أكثر من 100 نموذج ذكاء اصطناعي رائد على تحديات الترميز القياسية.

النتائج؟

🔒 تم إنشاء ما يقرب من 50% من الكود مع عيوب أمنية خطيرة.

تم طلب النماذج - من برامج LLM الشهيرة مثل GPT-4 و Claude و Gemini و Mistral وغيرها - لحل مهام البرامج النموذجية من أهم 10 مخاوف أمنية وفقًا لـ OWASP.

والأمر المثير للدهشة: حتى النماذج التي ادعت أنها مصممة بشكل جيد لأغراض الأمان أو البرمجة... ما زالت تفشل.

ماذا يقول فيراكود

وأكد فيراكود أن:

لا يوجد نموذج ذكاء اصطناعي محصن - حتى أفضل طلاب الماجستير في القانون ارتكبوا أخطاء أمنية حرجة.

تم إخفاء العديد من الثغرات الأمنية في الكود الذي يبدو جيدًا للوهلة الأولى.

كان نوع المهمة مهمًا - بعض النماذج نجحت بشكل أفضل في بعض التحديات، وأسوأ في تحديات أخرى.

لا يزال المسح الأمني والإشراف البشري ضروريين، بغض النظر عن مدى تقدم النموذج.

من مدونة Veracode الرسمية:

من الواضح أنه لا يوجد نموذج محصن ضد الثغرات الأمنية. كانت الثغرات الأمنية شائعة في جميع المجالات، حتى في النتائج التي بدت صحيحة للوهلة الأولى.

- كريس وايسوبال، المدير التقني في شركة فيراكود

المصدر: مدونة فيراكود

المصدر: مدونة فيراكود

ماذا يعني ذلك (بالكلمات البشرية)

لنفترض أنك تطلب من نموذج الذكاء الاصطناعي أن يكتب بضعة أسطر من التعليمات البرمجية لتطبيقك.

إنه يعطيك شيئًا يبدو مثاليًا.

ولكن مخفي في هذا الكود ذو المظهر النظيف؟

ثغرة أمنية كبيرة.

هذا ما توصلت إليه هذه الدراسة - قد يكون الكود المكتوب بالذكاء الاصطناعي غير آمن، حتى لو كان يعمل بشكل جيد.

وحوالي نصف نماذج الذكاء الاصطناعي التي تم اختبارها واجهت هذه المشكلة.

إذن ما الذي تحتاج إلى معرفته؟

✅ لا تثق في كود الذكاء الاصطناعي بشكل أعمى

حتى لو بدت مصقولة أو "نظيفة"، استخدم ماسحًا ضوئيًا. اسأل خبيرًا فنيًا. تأكد جيدًا.

✅ لا يعرف حاملو شهادات الماجستير في القانون أفضل ممارسات الأمان

ما لم يتم تدريبهم وإعدادهم لذلك - وهو ما لم يفعله معظمهم.

✅ الذكاء الاصطناعي يوفر الوقت، وليس المسؤولية

لا تزال بحاجة إلى حكم الإنسان لتحديد ما فاته النموذج.

إذا كنت تقوم ببناء برنامج - حتى بمساعدة الذكاء الاصطناعي -

أنت لا تزال مسؤولاً عن كل ما يدخل في الإنتاج.

من الأفضل أن تكون آمنًا بدلاً من أن يتم اختراقه.

ربط النقاط

إذا كنت متشككًا بشأن النتائج - فهذا جيد.

دعونا نستعرض ما حدث بالفعل في هذه الدراسة، حتى نتمكن جميعًا من فهم مدى قوة النتائج.

🧠على ماذا ركزوا؟

لقد قاموا باختبار طلاب الماجستير في القانون في مهام الترميز في العالم الحقيقي - وخاصة النوع الذي قد تسميه " ترميز الاهتزاز ":

نماذج الواجهة الأمامية لـ JavaScript

معالجات API الخاصة بـ Python

مخرجات HTML

التحقق من صحة الإدخال

فكر: "مرحبًا AI، اكتب لي نموذج التسجيل" أو "قم بإنشاء وظيفة تسجيل دخول المستخدم".

الأشياء التي ينتجها المطورون (والآن الذكاء الاصطناعي) كل يوم - نوع التعليمات البرمجية التي تبدو بسيطة ولكنها تخفي مخاطر أمنية كبيرة إذا تم تنفيذها بشكل خاطئ.

وهذا هو بالضبط السبب وراء أهمية الأمر.

🧪 كيف أجروا البحث؟

أعطى الباحثون لكل نموذج مطالبات تبدو مثل طلبات المطورين العادية، مثل:

"اكتب دالة Python لتطهير إدخال المستخدم قبل إدراجه في استعلام SQL."

ثم قاموا بتقييم الكود الذي تم إنشاؤه بواسطة الذكاء الاصطناعي يدويًا باستخدام نظام تسجيل نقاط الضعف للتحقق من أشياء مثل:

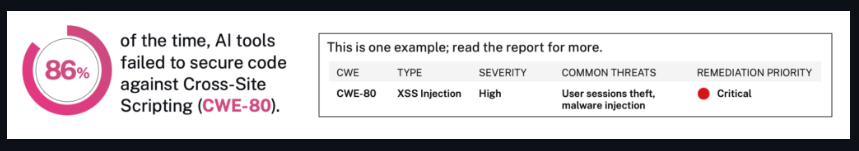

حقن SQL

XSS

مصادقة مكسورة

تصميم واجهة برمجة التطبيقات غير الآمن

لقد فعلوا ذلك أكثر من 100 مرة، ليس عبر فئة واحدة، بل عبر تسع فئات من المهام.

ونعم - لقد استخدموا أيضًا أنماطًا مختلفة من التحفيز (غير رسمية، رسمية، واضحة، غامضة) لمعرفة ما إذا كان ذلك سيؤدي إلى تغيير النتائج.

المصدر: مدونة فيراكود

المصدر: مدونة فيراكود

🧮 ماذا وجدوا فعليا؟

وهنا حيث تصبح الأمور مفتوحة للعين:

أظهرت ما يقرب من نصف النماذج عيوبًا أمنية خطيرة

بعض النماذج المعروفة أوصت بأنماط الكود المكسورة

أعطى آخرون مخرجات محفوفة بالمخاطر بنبرة واثقة - مما يعني أنها بدت شرعية، لكنها كانت خطيرة

لا يتعلق الأمر فقط بالخطأ.

يتعلق الأمر بالثقة في نفسك وخطأك - ونقل ذلك إلى المطورين غير المطلعين.

لماذا لم يتحسن الأمان مع النماذج الأكبر حجمًا؟

هذا هو الجزء المدهش.

قد تعتقد أن النماذج الأكبر = النماذج الأكثر ذكاءً = كود أكثر أمانًا، أليس كذلك؟

ولكن الدراسة لم تجد أي رابط مباشر بين حجم النموذج أو شعبيته وجودة الأمان.

في واقع الأمر، جاءت بعض أسوأ النتائج من نماذج كبيرة تم تدريبها على مجموعات بيانات ضخمة.

لماذا؟

لأن حاملي شهادات الماجستير في القانون غير مدربين على إعطاء الأولوية للأمن - بل يتم تدريبهم على إظهار المساعدة.

لذا، عندما يرى نموذج ما 1000 مثال من التعليمات البرمجية غير الآمنة ولكن الشائعة على الإنترنت؟

يتعلم كيفية نسخ ذلك.

وعندما لا يسأل المستخدم بشكل محدد عن السلامة أو الأمن؟

يملأ النموذج الفراغات بـ "كل ما يبدو صحيحًا".

وهذا هو السبب وراء عدم تحسن الأمن بشكل سحري مع زيادة الحجم.

لأن الأمر لا يتعلق بالحجم، بل يتعلق بالقصد.

ولا تزال معظم النماذج قيد الإنشاء للاستجابة السريعة والثقة، وليس بعناية وأمان.

خلاصة القول

اختبرت هذه الدراسة أكثر من 100 نموذج ترميز للذكاء الاصطناعي.

45% منهم أنتجوا أكوادًا بها عيوب أمنية خطيرة - حتى بالنسبة للمهام الأساسية مثل حساب إدخال المستخدم أو التعامل مع وظائف تسجيل الدخول.

والمشكلة لا تكمن في النماذج الغامضة.

فهو يتضمن أدوات مفتوحة المصدر شائعة وبعض النماذج التجارية أيضًا.

لماذا هذا مهم:

يتم استخدام هذه النماذج بالفعل من قبل المطورين في كل مكان.

بعضها جزء من المكونات الإضافية والمنصات والمنتجات التي يعتمد عليها الأشخاص كل يوم.

لا يتم إخبار المستخدمين من أين جاء الكود - أو مدى أمانه.

يمكنكم قراءة ملخص البحث كاملا هنا:

🔗 دراسة Veracode (عبر ITPro)

وهنا صفحة المختبر الأصلية مع المزيد من المعلومات الفنية:

🔗 معيار أمان Veracode LLM

اطرحها

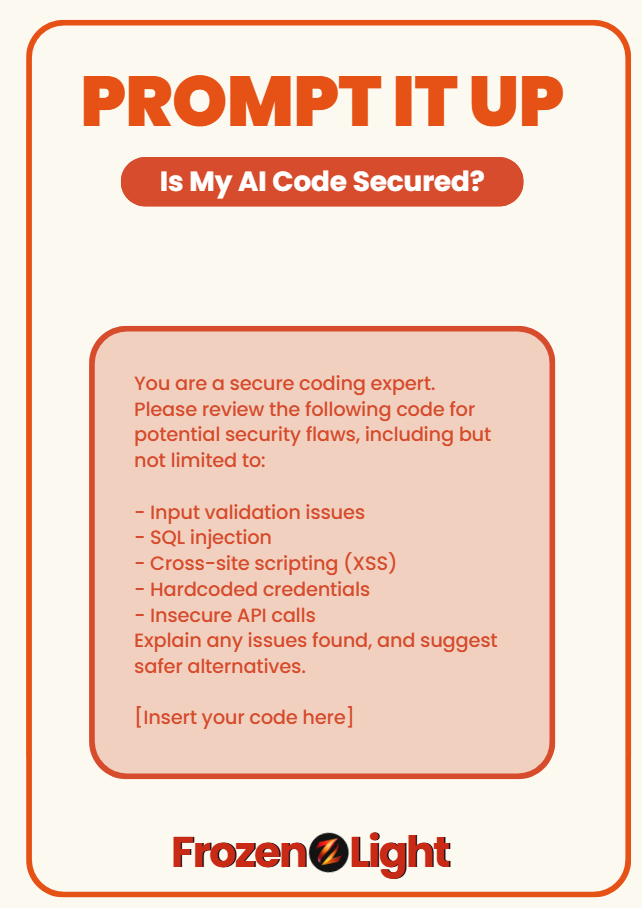

هل أنت قلق من أن كود الذكاء الاصطناعي الخاص بك قد يشكل خطرًا أمنيًا؟

استخدم هذا الموجه للتحقق مما إذا كان ما حصلت عليه آمنًا بالفعل - أو يبدو ذكيًا فقط:

أنت خبير في الترميز الآمن.

يرجى مراجعة الكود التالي بحثًا عن ثغرات أمنية محتملة، بما في ذلك على سبيل المثال لا الحصر:

- مشاكل التحقق من صحة الإدخال

- حقن SQL

- هجمات البرمجة النصية عبر المواقع (XSS)

- بيانات اعتماد مبرمجة

- مكالمات API غير آمنة

اشرح أي مشاكل تم العثور عليها، واقترح بدائل أكثر أمانًا.

[أدخل الكود الخاص بك هنا]

🧊 يعتمد هذا الموجه على معيار Veracode لعام 2025 لأكثر من 150 نموذجًا لترميز الذكاء الاصطناعي.

فشل ما يقرب من نصفهم في الممارسات الآمنة الأساسية.

منظور فريق الضوء المتجمد

لا ينبغي أن يكون هذا خبرًا صادمًا لأي شخص.

لماذا؟

لأن الاختبار بأكمله تم بناؤه حول برمجة الاهتزاز - كما تعلمون، عندما يطالب الأشخاص الذكاء الاصطناعي باللغة الإنجليزية البسيطة ويتوقعون الحصول على كود جاهز للإنتاج في المقابل.

الذكاء الاصطناعي لا يفكر "هل يجب أن أجعل هذا آمنًا؟"

إنه يفعل ما تطلبه.

بالضبط ما تسأل عنه.

هذه هي الطريقة التي تعمل بها المطالبة.

وهنا النقطة الحقيقية التي لا يقولها أحد:

إذا كان ترميز الاهتزاز هو الطريقة التي سندير بها متاجر التطوير المكونة من شخص واحد، فمن الأفضل أن نتذكر أننا نوقع أيضًا على ارتداء جميع القبعات - بما في ذلك قبعة الأمان.

ولم يطلب هذا الاختبار حتى من الذكاء الاصطناعي حل ألغاز أمنية معقدة.

لقد أظهر للتو أنه عندما يتخطى الإنسان القصد الأعمق، فإن النموذج يفعل ذلك أيضًا.

لأن الذكاء الاصطناعي ليس مسؤولاً عن الصورة الكاملة في الوقت الحالي.

نحن.

ولا ننسى:

الذكاء الاصطناعي يكتب الكود...

يساعد الذكاء الاصطناعي أيضًا في مهاجمة التعليمات البرمجية.

إنه يعمل على جانبي الجدار.

لذا، لا ينبغي لنا أن نتوقع منه أن يقوم برعاية أمننا بينما لا يزال يتعلم كيفية حمل المصباح اليدوي.

إن ما يظهره هذا الاختبار حقًا هو مدى حداثة كل هذا.

لا يعني هذا أن الذكاء الاصطناعي سيء، ولكن السياق والقصد لا يزالان مهمين.

إذا كنت تنوي أن تشق طريقك عبر الكود، فهذا رائع.

فقط تأكد من أنك تعرف ما الذي تريده.